共计 991 个字符,预计需要花费 3 分钟才能阅读完成。

近期,苹果公司的六名工程师进行的一项新研究揭示了先进大型语言模型在逻辑推理方面的脆弱性。这项研究指出,这些模型在面对常见基准问题的微小变化时,其数学“推理”能力可能极其脆弱且不可靠。

研究结果表明,大型语言模型使用的概率模式匹配缺乏真正可靠的数学推理能力所需的底层概念的正式理解。研究人员假设:“当前的大型语言模型不具备真正的逻辑推理能力,它们只是试图复制在其训练数据中观察到的推理步骤。”

混合测试方法

在题为“GSM-Symbolic: Understanding the Limitations of Mathematical Reasoning in Large Language Models”的预印本论文中,研究人员从 GSM8K 的标准化集合中选择了超过 8,000 个小学水平的数学应用题,并采用了一种新颖的方法,动态地将某些名称和数字替换为新值。这种方法有助于避免因将静态的 GSM8K 问题直接输入 AI 模型的训练数据而可能导致的“数据污染”。

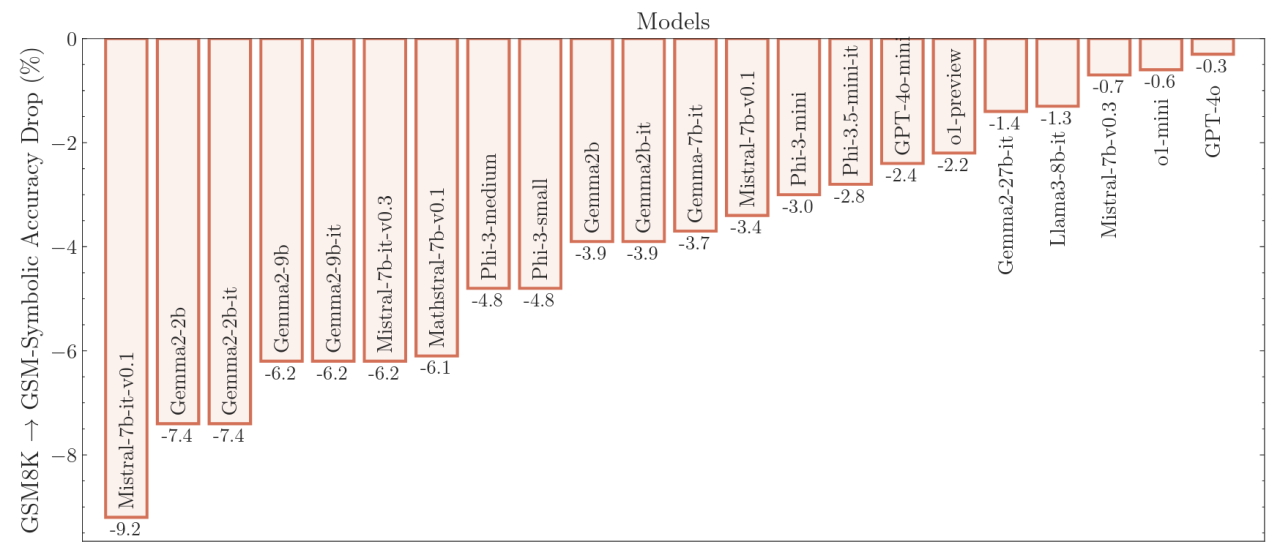

然而,当研究人员在 GSM-Symbolic 上测试了 20 多个最先进的 LLM 时,他们发现与 GSM8K 相比,平均准确率普遍下降,性能下降幅度在 0.3% 到 9.2% 之间,具体取决于模型。结果还显示,在 50 次使用不同名称和值的 GSM-Symbolic 运行中,准确率存在高变异性。

干扰信息的影响

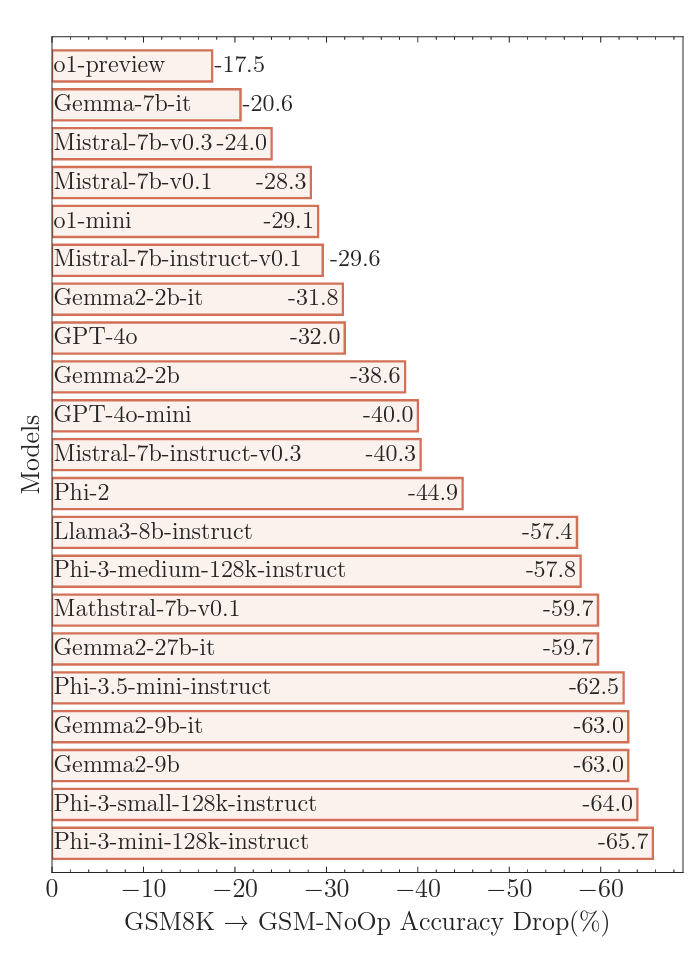

当苹果研究人员通过在问题中添加“看似相关但最终无关紧要的陈述”来修改 GSM-Symbolic 基准时,测试的 LLM 表现更差。添加这些干扰信息导致与 GSM8K 相比,准确率出现研究人员所称的“灾难性性能下降”,下降幅度从 17.5% 到惊人的 65.7% 不等,具体取决于测试的模型。

这种“关键缺陷”表明“模型推理过程中存在更深层次的问题”,无法通过微调或其他改进来解决。

理解的幻觉

这项新的 GSM-Symbolic 论文的结果在 AI 研究领域并不完全新颖。最近的其他论文和研究同样指出,大型语言模型实际上并不进行正式推理,而是通过对其庞大训练集中最相似数据的概率模式匹配来模仿推理。

AI 专家 Gary Marcus 认为,AI 能力的下一个重大飞跃只有在这些神经网络能够整合真正的“符号操作,其中一些知识以变量和这些变量上的操作的形式真正抽象地表示,就像我们在代数和传统计算机编程中看到的那样 …”才能实现。

在此之前,我们将看到这种脆弱的“推理”,它可能导致 AI 模型在数学测试中失败,而计算器从未如此。