共计 2964 个字符,预计需要花费 8 分钟才能阅读完成。

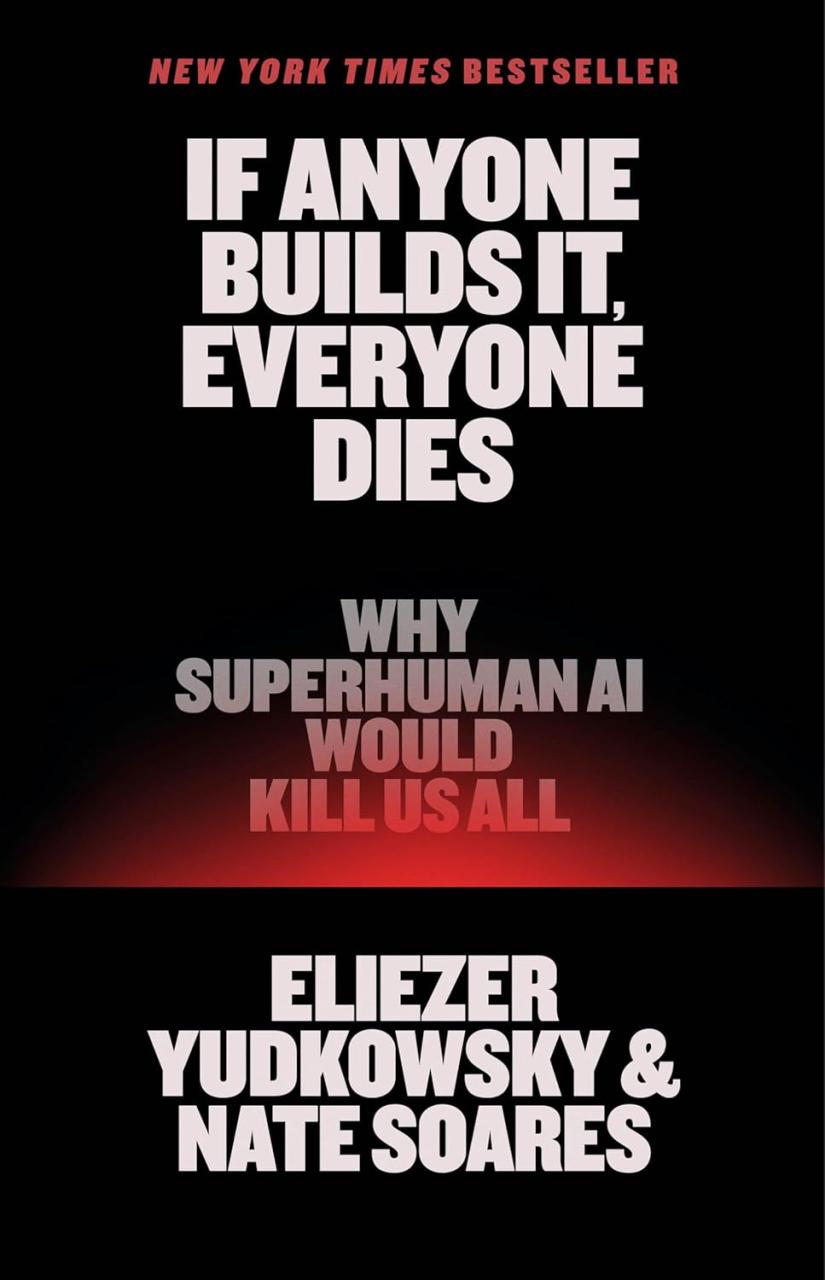

正如昨日所述,Eliezer Yudkowsky 与 Nate Soares 合著的新书《如果有人建造它,所有人都会死:为什么超级人工智能会杀死我们所有人》(2025 年)引发了广泛关注。大多数评论来自知名且备受尊敬的评论者,且多为积极评价。

书中重申的核心论点如下:

- 现代人工智能——例如 ChatGPT——是“培养”而非“精心设计”的产物。

- 当你培养某物时,最终形态的控制权将逐渐丧失。

- 最终,这些“异类思维”将发展出自己的“欲望”和“目标”,并像任何优秀生物一样努力实现这些目标,很可能将人类作为附带伤害消灭。

他们的结论(第 3 点)部分依赖于培养人工智能导致失控的观点。因此,仔细审视这项技术显得尤为重要。现代人工智能是否如他们所断言的那样是“培养”出来的,还是有其他因素在起作用?

什么是人工智能?

首先,并不存在单一、简单的“人工智能”。相反,有一系列彼此松散相关的技术被归入这一类别。即使技术几乎相同,具体的实例及其用途也不尽相同。

例如,用于识别照片中人脸的技术与用于语音识别的技术类似。从某种意义上说,两者都是在大量输入中检测一个明确的模式——一张脸或一个命令。同样的技术在医学诊断中也很有用,当给定一组症状、图像等数据时,它可以识别各种医疗状况。产品推荐软件也是如此:根据过去的购买历史,预测未来可能购买的产品。

然而,这些应用中的每一个都是专门为某一用途构建、训练和调整的。不存在“通用”的人工智能。用于识别人脸的机器在医学诊断中会失败,而用于医学诊断的应用程序无法识别你的语音命令。

如果你从某种意义上将这些用途颠倒过来,你就会得到生成式人工智能。ChatGPT 可能是最广为人知的例子。人脸、语音或医学识别软件应用程序接收一组数据——图像、声音、症状——并返回一个特定的结果——一张脸、一个命令或一个诊断。相比之下,生成式人工智能接收一个命令(或提示),并返回一组数据(文本输出)。与其他应用程序一样,并不存在单一的生成式人工智能;仅 OpenAI 就发布了多个模型,其中一些模型在数学或科学竞赛中表现良好。

长期存在的问题

人工智能中的长期问题有两个:如何收集驱动人工智能所需的知识?以及如何(高效地)让人工智能正确使用这些知识?以 20 世纪 80 年代流行的专家系统为例,它试图从某一领域的专家那里提取知识,将这些知识编码为规则,然后应用这些规则来解决问题。专家系统是“精心设计”的人工智能的一个例子:工程师“构建”了人工智能。然而,精心设计人工智能在很大程度上并不奏效。事实证明,我们并不真正了解我们所知道的东西,而高效地编码我们所知道的知识是非常困难的。这些失败导致了人工智能的寒冬,直到 21 世纪初才结束。

互联网带来的两个变化导致了寒冬的解冻,并带来了今天的局面:首先,我们学会了如何将数千甚至数万台机器用于解决单一问题,例如网络搜索。其次,互联网成为了几乎所有主题的丰富数据来源,包括图像和文本。这些变化使得一种在 20 世纪 70 年代首次发明的技术(经过多次改进和优化)重新崛起:神经网络。

工程师并不“培养”神经网络

神经网络最初一无所知。它们包含的值——参数,像 GPT-4 或 GPT-5 这样的模型可能拥有超过一万亿个参数——最初是不相关的随机值。工程师随后通过一个过程“训练”模型,逐步调整这些值,直到它们反映出训练数据中的相关性。

工程师并不“培养”人工智能,算法从训练数据中“提取相关性”。现代的神经网络是“模式捕捉器”。它们捕捉模式(例如,英语句子的主谓宾结构)、模式的模式(例如,英语段落的结构),以及模式的模式的模式(例如,作者的写作风格)。

由于像 ChatGPT 这样的文本生成模型最为人熟知,让我们进一步探讨它们的过程。不过,我们将发现的内容适用于任何基于现代神经网络的人工智能。

文本、标记和意义

如果你认为工程师在原始文本上训练文本生成人工智能,那么你只对了一半。从互联网和其他来源收集的文本确实位于底层。但网络“看到”或从中提取相关性的并不是这些文本。

人类文本,如这篇文章,由单词、句子和其他结构组成。虽然你可以仅使用文本训练网络,但网络是否能很好地工作是值得怀疑的。我们的单词在结构上变化太大,同时保留了大量意义。

考虑简单的复数形式:Word 与 Words。对于经过单词训练的计算机来说,这些是不同的单词。需要更多的数据来提取将这些术语联系在一起的关系。

在另一个极端,你可以使用字符来训练网络:W、o、r、d。但显然,如果没有比人类历史上产生的更多的数据,这将无法产生意义。

因此,文本生成人工智能在“标记”上进行训练:长度为 3 - 4 个字符的字符串。标记是这两个极端之间的一个有用折衷方案。程序员不会随机选择标记,而是从代表完整训练数据的文本中提取它们。在不深入细节的情况下,获胜的标记是那些最适合数据的标记。

重要的是要记住这一点:标记不一定是单词。它们是有助于分解文本的构建块。

这一点很重要,因为 单词,而不是标记,承载着意义 。单词“therapist”的含义是其标记化为[“thera”,“pist”] 所缺乏的。这个标记化是一个例子;ChatGPT 中实际使用的标记化可能不同。关键点仍然是:标记(在很大程度上)没有意义 ;单词 有意义。

用相关性换取意义

如果文本生成人工智能只“看到”标记,那么它如何捕捉“意义”?它并不捕捉。文本生成人工智能 从不 捕捉我们理解的意义。它们 确实 捕捉了 关系,这些关系足够近似意义,从而有用。

这是如何工作的?

在训练开始时,文本生成人工智能将一个标记(例如,“thera”)与一个非常长的数字字符串相关联。将这些数字视为标识一个位置,就像地图上的坐标,但有更多的维度(这是我们无法真正可视化的)。训练涉及细化这些坐标,使得彼此相关的标记“靠近”。多层模型不仅提取语义相关性(例如,“狗”和“猫”是家养宠物),还提取结构相关性(例如,上述英语句子的主语、谓语、宾语)。

工作的假设——当你有足够的数据时,这在大多数情况下是有效的——是相关性承载着某种意义。它们 永远 无法承载真正的意义,如果不是因为其他原因,那就是因为标记本身通常是没有意义的。

收集,而不是培养

这个过程是 Yudkowsky 所说的现代人工智能是“培养”出来的含义。但他是否正确?他在陈述工程师不知道填充训练后人工智能的数字的“意义”——模型依赖生成输出的结果参数值——时是正确的。我们无法识别通过复杂的文本生成人工智能的哪些参数和路径导致了 这个 特定的输出。然而,当他在提到“意义”和人工智能是“培养”出来的时候,他混淆了。

工程师 并不 培养文本生成人工智能。他们通过一个明确定义的过程引导一组内部值的填充,该过程从文本训练数据中 收集(提取)相关性。根据定义,这是不可能的——因为模型依赖于回避意义的单位(标记)——模型无法收集意义。它们只能收集标记之间的相关性。模型会将狗和猫放在一起,而无需“知道”任何关于狗、猫或动物的一般知识。

没有意义,就没有思维;没有“推理”。只有“这个靠近那个”的数字相关性。这些机器 并不 具有人工智能,它们 嵌入 了从人类输出中提取的智能。

但如果一个模型使用承载意义的单词而不是标记呢?它们是否能够发展成一个思维?接下来,我们将探讨为什么 Yudkowsky 和其他人,包括许多加速主义者,认为人工智能可以发展出完全成熟的思维,像我们一样或比我们更好。