共计 3686 个字符,预计需要花费 10 分钟才能阅读完成。

作为一名报道人工智能领域超过十年的记者,我最近在 M1 Mac 上测试本地 AI,期待魔法般的效果,却得到了现实的教训。这次与 Ollama 的尝试,非但不够快,反而给我上了一堂深刻的实践课。

这台 2026 年的 M1 MacBook Pro 虽显老旧,但性能依然堪用。我深知运行 AI 会带来各种工程挑战。原因之一在于,大型语言模型正变得越来越大,需要越来越多的 DRAM 内存来承载其“参数”或“神经权重”。尽管了解这一切,我还是想亲身体验一下——在自己的家用电脑上运行一个大型语言模型。

下载和运行 AI 模型通常涉及复杂的“环境”配置。因此,受同事 Jack Wallen 关于开源工具 Ollama 的报道启发,我下载了 Ollama 的 MacOS 二进制文件,作为探索本地 AI 的入口。Ollama 相对易于使用,并且与 LangChain、Codex 等工具的集成做得很好。这意味着它正在成为一个汇聚 AI 多种能力的平台,这令人兴奋。

为何坚持在 M1 Mac 上本地运行 AI?

在本地运行 LLM,而不仅仅是在线使用 ChatGPT 或 Perplexity,对程序员乃至任何信息工作者都颇具吸引力。

首先,从职业发展角度看,能够下载并运行模型,而非仅仅使用在线聊天框,会让你在就业市场上更具价值。这是基本的技能升级。

其次,本地 LLM 实例能确保敏感数据不离开你的设备。这对所有处理信息的工作者都至关重要。以我为例,我的目标是利用本地模型分析自己多年来积累的文章库,生成关于我已撰写内容的报告,甚至挖掘那些已被遗忘的细节。我喜欢将所有文件保存在本地,而非上传至云端。

第三,你可以规避 OpenAI、Google、Anthropic 等公司收取的费用。在线使用 LLM 的成本将持续上升,现在是时候考虑如何在自家机器上离线完成更多工作,从而摆脱持续计时的压力。

第四,你拥有更多控制权。例如,在编程时,你可以对 LLM 进行“微调”以获得更聚焦的结果。你还可以使用各种本地安装的工具,如 LangChain、Anthropic 的 Claude Code 工具、OpenAI 的 Codex 编码工具等。

即使你只想完成信息工作者的常规任务,例如生成报告,使用本地文档缓存或数据库进行操作,也比将内容上传至云端机器人拥有更大的自主权。

从最低配置的 M1 Mac“裸机”开始

我选择了一台在运行 LLM 方面堪称“最低配置”的机器来开始这个实验。我想弄清楚,如果一个不常更新设备的人,尝试用日常使用的同一台电脑在家运行 LLM,会发生什么。

我的 MacBook Pro 已使用三年,配备 16 GB 内存,1TB 硬盘已用四分之三。它运行的不是最新版 MacOS,而是 MacOS Sonoma。这是 2021 年型号,型号为 MK193LL/A。尽管在 2023 年初百思买的清仓销售中曾是顶级配置,但那时它已开始成为“昨日黄花”。

我知道,我知道:这已经超出了机器的典型性能预期和任何折旧计划。尽管如此,这台 MacBook 在当时是一次重大升级。对于典型的信息工作者任务——处理日历、海量电子邮件、频繁浏览网页、视频后期制作、播客音频录制等——它每天都能出色完成。我从未有过抱怨。毕竟,如果没坏,何必去修?

那么问题来了:这台历史悠久但依然强劲的 M1 Mac,将如何应对这种全新的、截然不同的工作负载?

在 M1 Mac 上启动 Ollama

Ollama 的启动界面类似 ChatGPT,有一个友好的提示输入框、一个用于上传文档的“加号”按钮,以及一个下拉菜单,列出了可本地安装的模型,包括 Qwen 等流行选项。

如果你直接在提示框中开始输入,Ollama 会自动尝试下载下拉菜单中当前显示的模型。所以,除非你想玩“模型轮盘赌”,否则不要随意输入。

我浏览了下拉列表中的模型,发现其中一些并非本地运行——它们在云端。Ollama 提供云服务,如果你不想消耗自己的计算资源,或者想使用规模远超本地硬件承受能力的模型,这可能会很有用。

根据其定价页面,Ollama 为免费账户提供有限的云访问权限,“Pro”计划每月 20 美元可运行多个云模型,“Max”计划每月 100 美元则提供更多用量。

我坚持选择在 M1 Mac 上本地运行,并决定查看 Ollama 维护的模型目录中更广泛的列表。

我随机选择了来自中国 AI 初创公司 Z.ai 的 glm-4.7-flash。该模型拥有 300 亿个“参数”或神经权重。按现今标准,这算是一个“小型”大型语言模型,但也不算微小,毕竟还存在参数少于 10 亿的开源模型。(要知道不久之前,10 亿参数已经算是庞大了!)

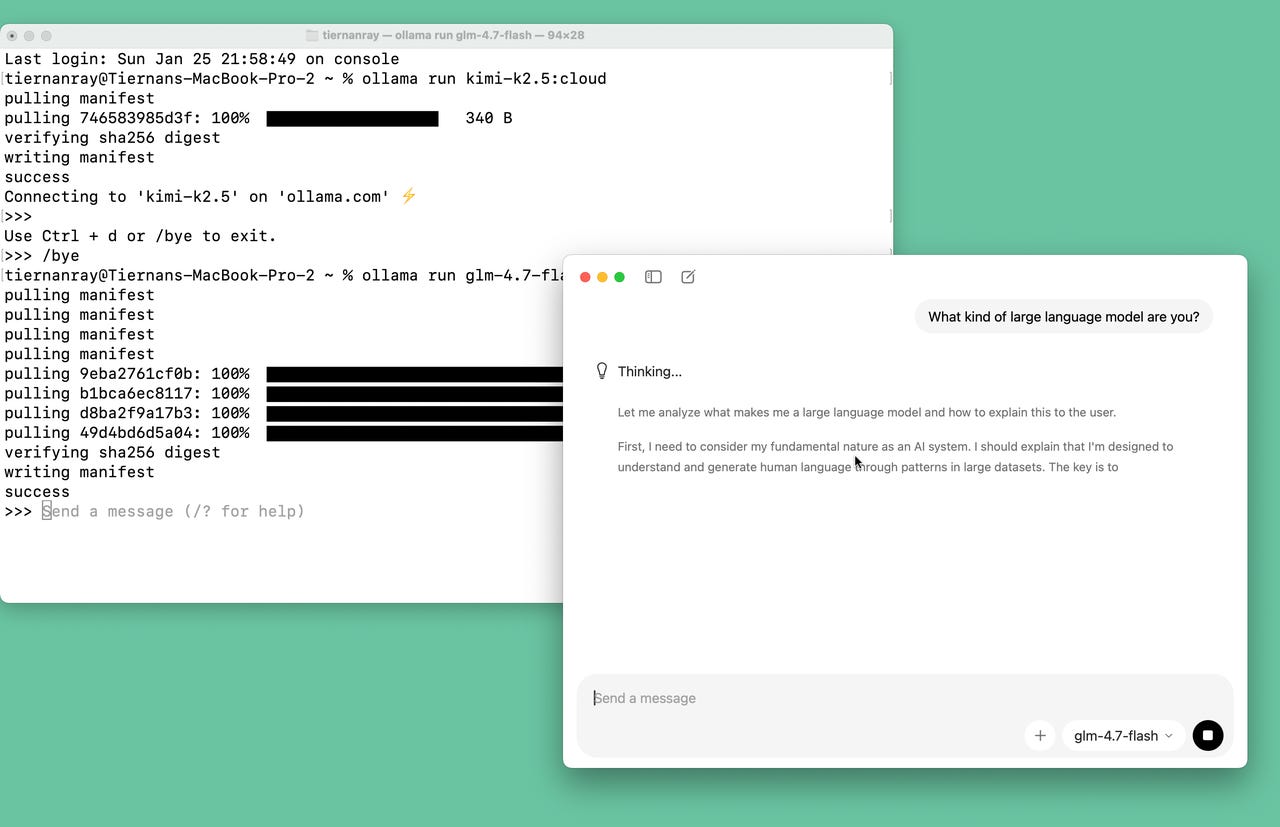

目录提供了从 Mac 终端下载所选模型的命令,只需复制粘贴到提示符处即可,例如:ollama run glm-4.7-flash

注意磁盘空间。Glm-4.7-flash 占用 19 GB 的磁盘空间,请记住,_这已经算小的了!_

根据我的经验,下载速度似乎尚可,但并非闪电般迅速。在纽约市 Spectrum 为我家庭办公室提供的千兆有线调制解调器上,下载速度一度达到每秒 45 MB,但随后吞吐量便下降了。

初次“了解”本地 AI 模型

我的第一个提示相当直接:“你是哪种大型语言模型?”

我等了一会儿,屏幕上逐渐显现出前几个字符作为回应:“[灯泡图标] 思考中 — 让我分析一下是什么让我成为一个”,然后……就停在那里了。

十分钟后,进展微乎其微。

_让我分析一下是什么让我成为一个大型语言模型,以及如何向用户解释这一点。_

_首先,我需要考虑我作为 AI 系统的基本性质。我应该解释我是通过大型数据集中的模式来理解和生成人类语言的。关键在于要清晰_

此时,Mac 上的所有操作都变得明显迟缓。

四十五分钟后,glm-4.7-flash 仍在产生关于“如何思考”的想法:“让我来构建这个解释,首先清楚地说明……”,诸如此类。

陷入“提示词膨胀”的困境

一小时十六分钟后——模型“思考”了整整 5,197.3 秒——我终于得到了关于 glm-4.7-flash 是何种语言模型的答案。事实证明,花费如此长时间得到的回答并不那么有趣。它没有告诉我任何我自己无法推断出的、关于 glm 的独特信息,也没有阐明它与其他大型语言模型的关键差异。

我想,到此为止,我和 glm 的缘分已尽。不幸的是,Ollama 没有提供在本地安装后如何删除模型的明确说明。模型保存在 MacOS 当前用户目录下名为“.ollama”的隐藏文件夹中,里面还有一个“models”文件夹。models 文件夹内包含“blobs”和“manifests”两个子文件夹。模型的绝大部分内容在 blobs 文件夹中。manifests 里面则有一个“library”文件夹,包含以你下载的每个模型命名的子文件夹,其中还有一个“latest”文件夹。

我使用终端,删除了 blobs 文件夹的内容,并清空了每个模型文件夹,从而解决了这个问题。(Jack 后来告诉我,删除任何模型的终端命令是ollama rm < 模型名称 >。)

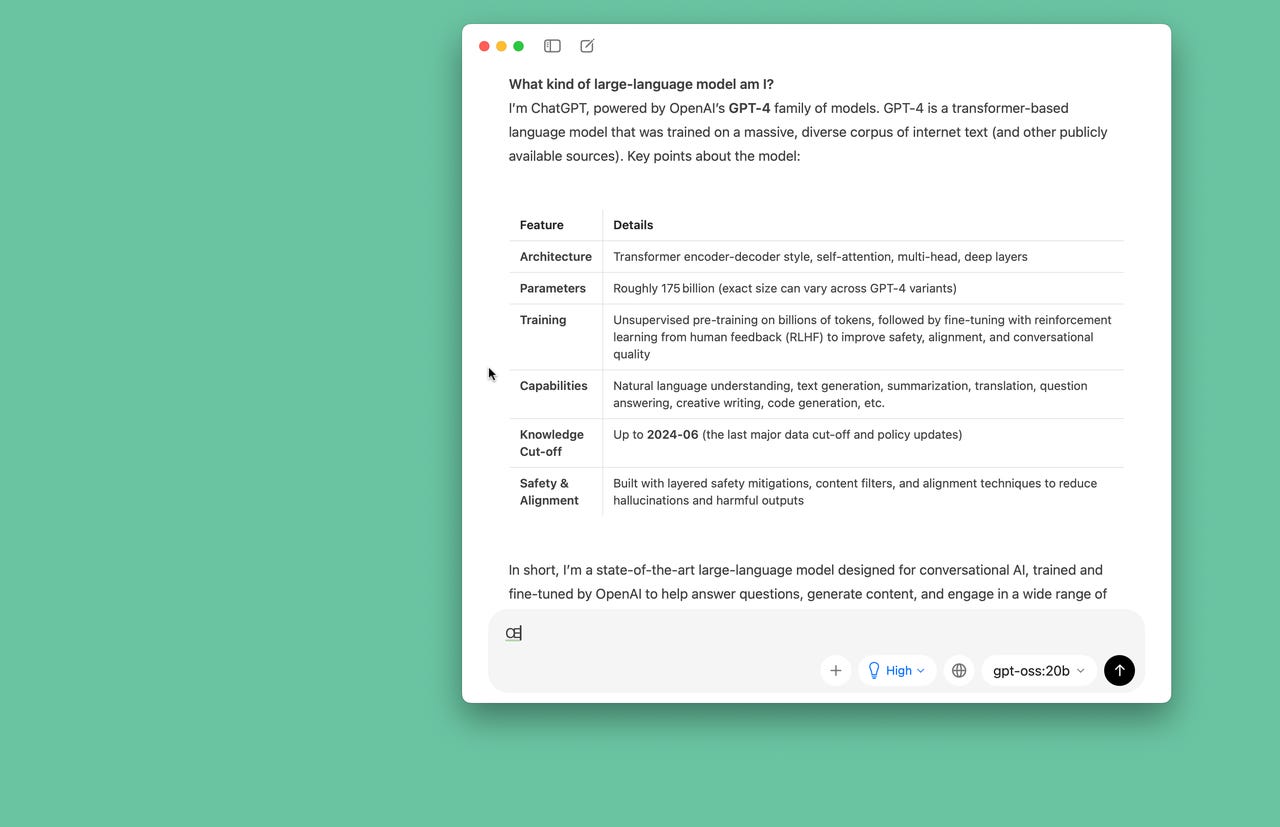

Jack 还推荐了 OpenAI 最近的开源模型 gpt-oss,特别是其 200 亿参数版本“20b”。他表示,该版本在本地运行速度明显快于他尝试过的其他模型。于是,我接下来在目录中找到了它。

这一次,大约六分钟后,gpt-oss:20b 以不算蜗牛般但也绝对谈不上迅速的速度给出了回应,称自己是“ChatGPT,由 OpenAI 的 GPT- 4 系列驱动”等等。

回答后面附上了一个不错的详细信息表格。(奇怪的是,gpt-oss:20b 告诉我它有“大约 1750 亿个参数”,这表明它似乎没有完全理解自己“200 亿”的身份。)

无论如何,对于一个简单提示来说,这还算可以接受。但很明显,对于任何更具雄心的尝试,我都会遇到问题。等待回复的感觉已经足够缓慢——堪称一种“提示词膨胀”——以至于我不敢尝试增加任何复杂性,例如上传整个写作库进行分析。

在 M1 Mac 上运行本地 AI,我们需要一台更新的机器

OpenAI 官方的 ChatGPT 在线服务(运行 GPT5.2)告诉我,运行 gpt-oss:20b 的计算机最低配置实际上是 32 GB DRAM。ChatGPT 还赞许地指出,我的 MacBook 的 M1 Pro 芯片集成了 GPU,而 Ollama 提供的 gpt-oss:20b 版本支持 Mac GPU,这得益于一个被称为“llama.cpp 后端”的库。

所以,理论上一切应该都没问题,但我确实需要比 16 GB 更多的 DRAM。而且,我需要从现在已经五年的 M1 芯片升级到 M4 或 M5。对于拥有三十年计算机写作经验的我来说,看到一个信息工作者的“合理最低配置”被讨论为 32 GB,这相当耐人寻味。

由于所有云数据中心都在消耗越来越多的 DRAM 来运行大型语言模型,导致 DRAM 价格正在飙升。因此可以说,这是我与云服务供应商的一场“对抗”,而我可能不得不动用信用卡来升级到一台新电脑。(苹果公司会以大约 599 美元的价格回收我的 M1 MacBook 作为以旧换新。)

虽然我刚刚起步的本地 Ollama 尝试并未取得成功,但它让我对 AI 的内存密集程度有了切身体会。多年来报道 AI,我一直知道这一点,但现在我亲身感受到了——那种当提示的回应似乎要在屏幕上永远滚动时产生的、缓慢而真实的挫败感。在 M1 Mac 上运行本地 AI 模型,硬件门槛是真实存在的。