共计 1003 个字符,预计需要花费 3 分钟才能阅读完成。

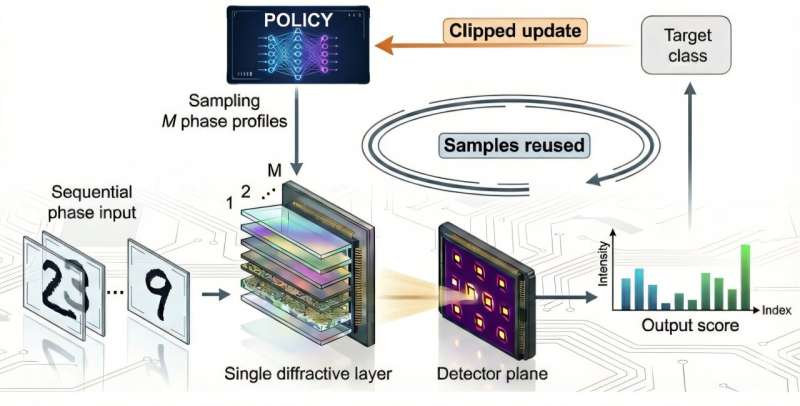

近端策略优化算法用于光学处理器的无模型原位训练。图片来源:加州大学洛杉矶分校工程与技术推进研究所

光学计算凭借其高速、低能耗的特性,已成为信息处理领域的重要方法。其中,衍射光学网络通过无源相位掩模和光的传播实现大规模并行计算,展现出巨大潜力。然而,当前系统面临一个关键瓶颈:在理想仿真环境中训练出的模型,往往难以在真实的实验条件下达到最优性能,因为失准、噪声和模型误差等因素难以被精准模拟和捕捉。

研究人员引入无模型训练新范式

在最新一期《光:科学与应用》杂志上,加州大学洛杉矶分校的研究团队提出了一种基于近端策略优化的无模型原位训练框架,专门用于衍射光学处理器。近端策略优化是一种以稳定性和样本效率著称的强化学习算法。与依赖数字孪生或近似物理模型的传统方法不同,该系统直接从真实光学测量中学习,直接在硬件上优化其衍射特征。

“与其费力地试图完美模拟复杂的光学行为,不如让设备从实际经验或实验中学习,”该研究的通讯作者、加州大学洛杉矶分校电气与计算机工程系校长教授艾多甘·奥兹坎表示。“近端策略优化使这一原位学习过程变得快速、稳定,并能适应现实的实验条件。”

实验演示与应用成果

为验证近端策略优化能够有效指导光学处理器执行计算任务——即便对实验装置的底层物理原理一无所知,研究团队进行了全面的实验测试,展示了该方法在多种光学任务中的适应能力。例如,该系统成功学会了通过随机、未知的扩散器聚焦光能,其训练速度远超标准的策略梯度优化,显示出其在光学参数空间中高效探索的能力。

同一框架还被应用于全息图生成和像差校正。在另一项演示中,衍射光学处理器利用在光学硬件上采集的测量数据进行训练,实现了手写数字的分类。随着原位训练的推进,每个输入数字对应的输出图案变得越来越清晰、可分,无需任何数字后处理即能显示正确分类结果。

优势与未来潜力展望

近端策略优化能够重复使用测量数据进行多步更新,同时约束策略的偏移幅度,从而显著减少了对实验样本的需求,并避免了训练过程中的不稳定行为,使其特别适合嘈杂的实际光学环境。这种方法的适用范围并不局限于衍射光学,还可推广到其他能够提供反馈并支持实时调整的物理系统中。

“这项工作代表了向智能物理系统迈出的重要一步:这类系统能够自主学习、适应并执行计算,而无需依赖实验装置的详细物理模型,”奥兹坎总结道。“该方法未来可扩展至光子加速器、纳米光子处理器、自适应成像系统以及实时光学人工智能硬件等领域。”