共计 1210 个字符,预计需要花费 4 分钟才能阅读完成。

Nvidia 将在 Hot Chips 2024 大会上展示其最新的 Blackwell 技术栈,这是一个为科技爱好者和专业人士提供深入了解 Nvidia 最新技术的机会。

前瞻性: Nvidia 计划在本周末进行预展,并在下周的主活动中详细展示其 Blackwell 技术栈。这将是 Nvidia 爱好者深入了解 Team Green 最新技术的激动人心的时刻。然而,文章未提及的是 Blackwell GPU 可能的延迟,这可能会影响产品的发布时间表。

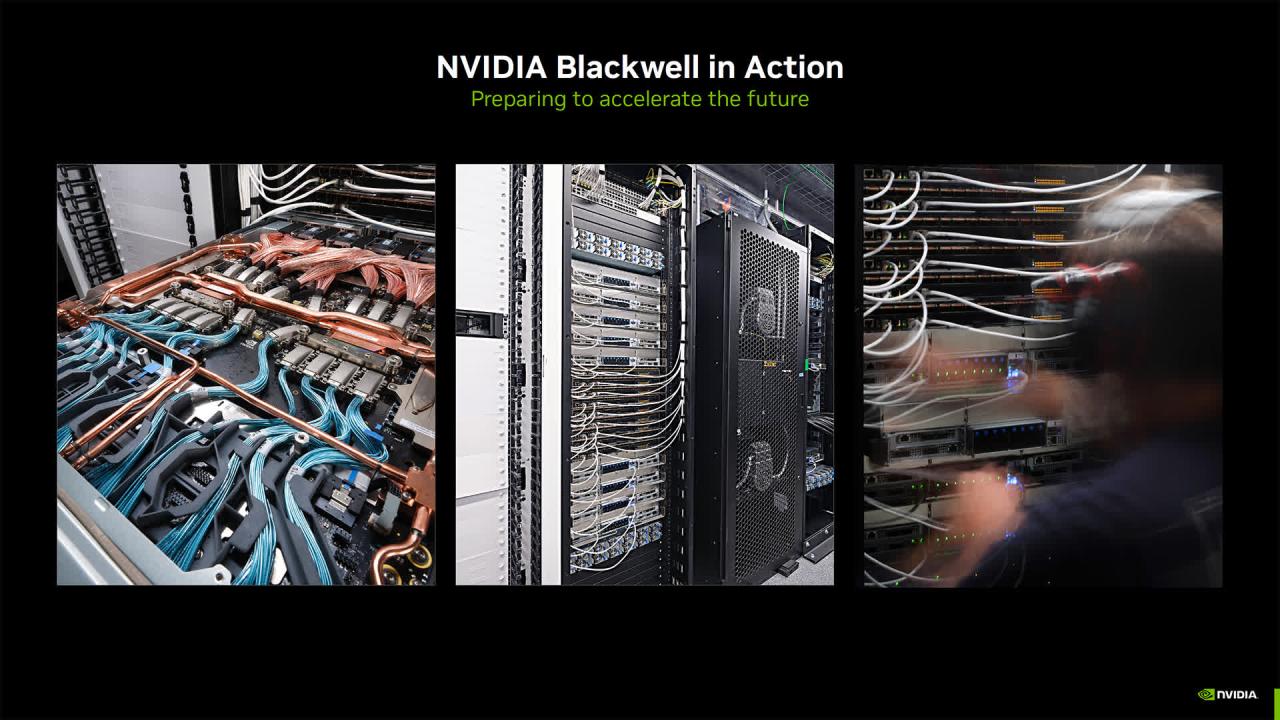

Nvidia 致力于通过其 Blackwell 平台重塑 AI 领域,该平台旨在超越传统 GPU 的功能,构建一个全面的生态系统。在 Hot Chips 2024 会议上,Nvidia 将展示其 Blackwell 服务器的设置和配置,以及各种先进组件的集成。

Nvidia 的演讲将涵盖多个领域,包括数据中心和 AI 战略,以及 Blackwell 的路线图。该路线图详细说明了明年发布 Blackwell Ultra,随后在 2026 年发布 Vera CPU 和 Rubin GPU,以及在 2027 年发布 Vera Ultra。Nvidia 已于去年六月在 Computex 上分享了这一路线图。

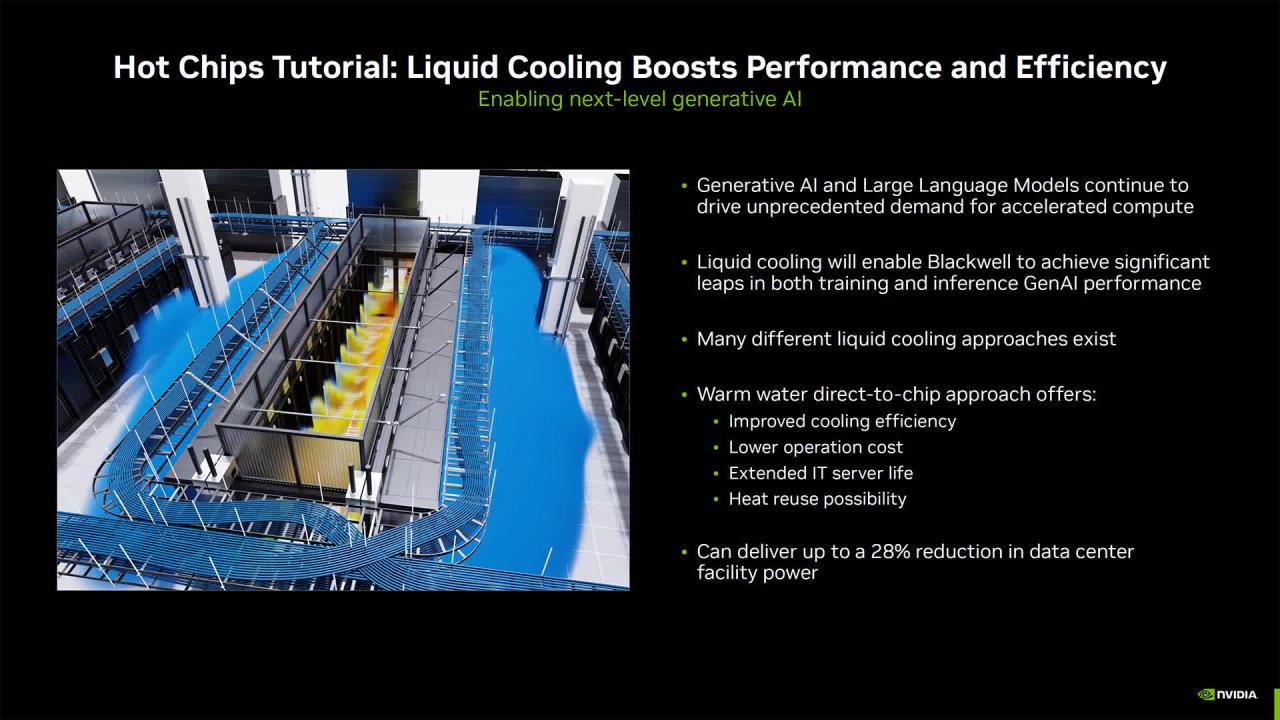

对于渴望深入了解 Nvidia Blackwell 栈及其不断发展的用例的科技爱好者来说,Hot Chips 2024 将提供一个探索 Nvidia 在 AI 硬件、液冷创新和 AI 驱动芯片设计方面最新进展的机会。

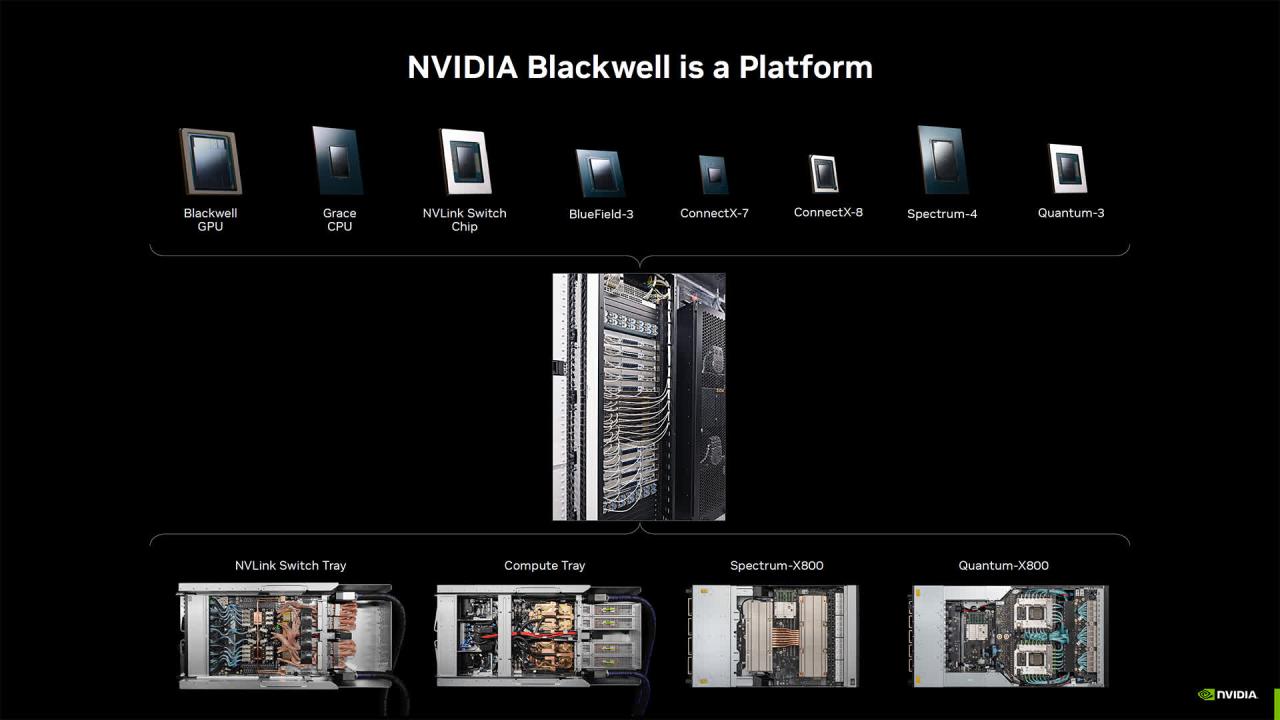

其中一个关键演讲将详细介绍 Nvidia Blackwell 平台,该平台由多个 Nvidia 组件组成,包括 Blackwell GPU、Grace CPU、BlueField 数据处理单元、ConnectX 网络接口卡、NVLink Switch、Spectrum 以太网交换机和 Quantum InfiniBand 交换机。

此外,Nvidia 将推出其 Quasar 量化系统,该系统结合了算法进步、Nvidia 软件库和 Blackwell 的第二代 Transformer 引擎,以增强 FP4 LLM 操作。这一发展承诺在保持 FP16 高性能标准的同时,实现显著的带宽节省,代表了数据处理效率的重大飞跃。

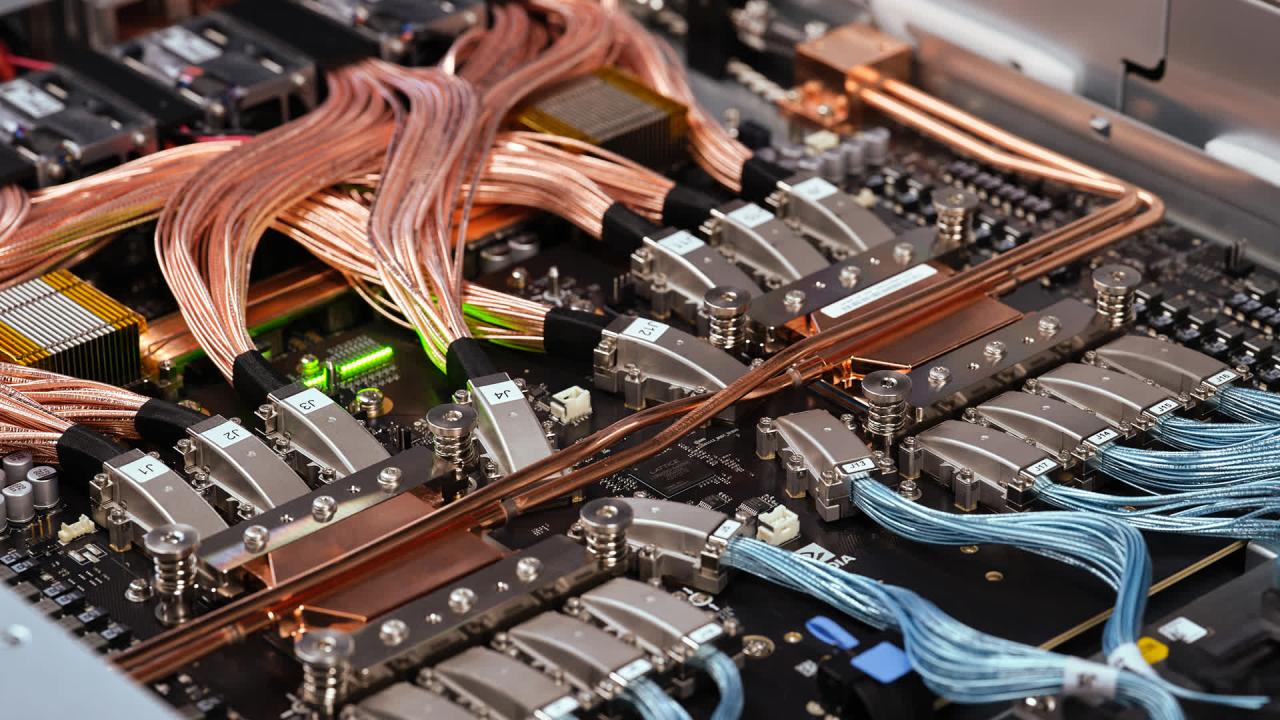

另一个焦点将是 Nvidia GB200 NVL72,这是一个多节点、液冷系统,配备 72 个 Blackwell GPU 和 36 个 Grace CPU。与会者还将探索 NVLink 互连技术,该技术以卓越的吞吐量和低延迟推理促进 GPU 通信。

Nvidia 在数据中心冷却方面的进展也将是一个讨论话题。该公司正在研究使用温水液冷,这种方法可以将能耗降低高达 28%。这种技术不仅降低了能源成本,还消除了对低于环境温度冷却硬件的需求,Nvidia 希望这将使其成为可持续技术解决方案的领先者。

在另一个环节,Nvidia 将讨论其使用基于代理的 AI 系统,这些系统能够自主执行芯片设计任务。AI 代理的实际应用示例将包括时序报告分析、单元簇优化和代码生成。值得注意的是,单元簇优化工作最近被认为是首届 IEEE 国际研讨会 LLM-Aided Design 的最佳论文。