共计 959 个字符,预计需要花费 3 分钟才能阅读完成。

在近日举行的 Microsoft Build 会议上,一场意外的抗议活动导致 Microsoft 的 AI 安全主管 Neta Haiby 意外泄露了关于 Walmart 使用 Microsoft AI 工具的机密信息。

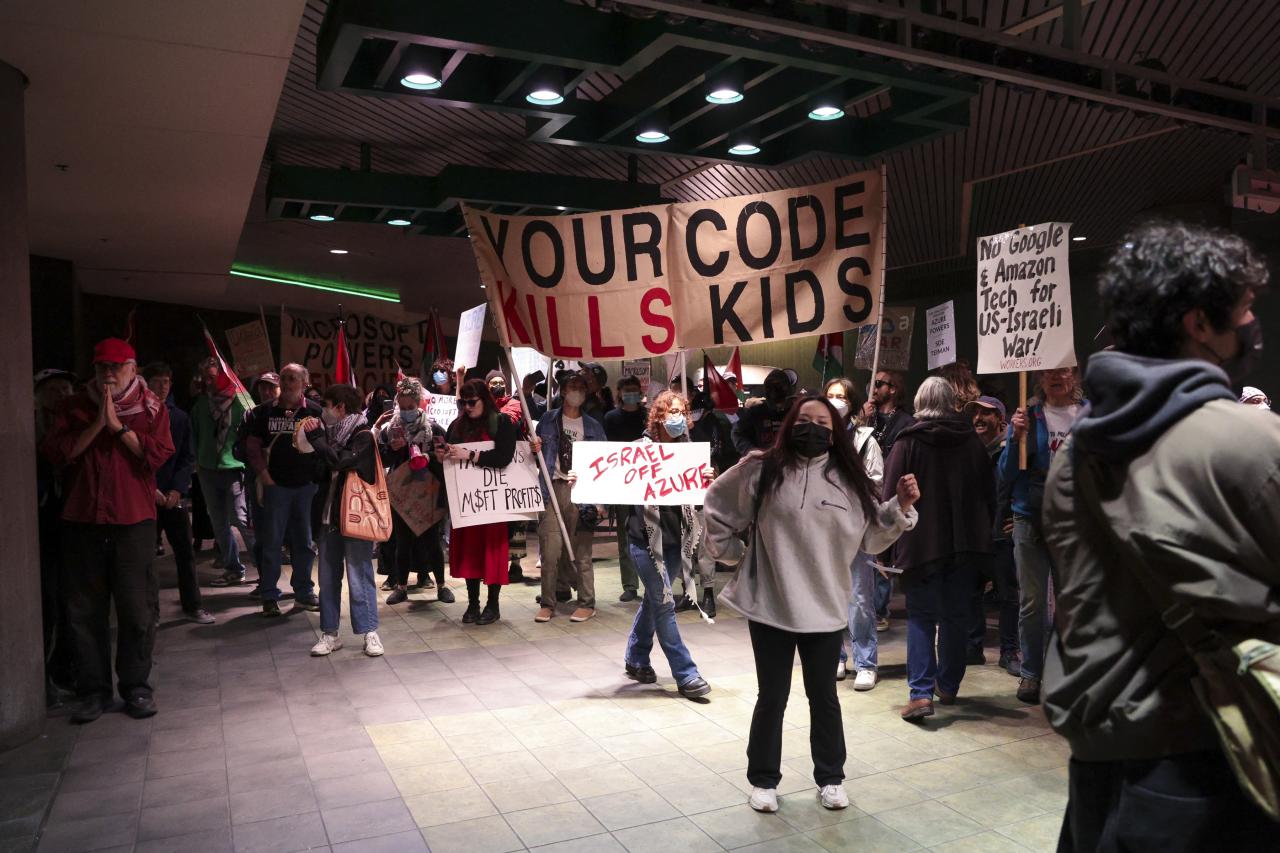

事件发生时,Haiby 正与 Microsoft 负责任 AI 主管 Sarah Bird 共同主持一场关于 AI 最佳安全实践的会议。两名前 Microsoft 员工突然打断会议,抗议公司与以色列政府的云合同。抗议组织 [No Azure for Apartheid] 的组织者 Hossam Nasr 高声指责 Microsoft 在巴勒斯坦的所谓“罪行”,并质疑公司如何在支持巴勒斯坦“种族灭绝”的同时谈论负责任 AI。

在抗议者被带出会场后,会议迅速恢复。然而,Haiby 在共享屏幕时意外切换到 Microsoft Teams,展示了关于 Walmart 即将使用 Microsoft 的 Entra 和 AI 网关服务的机密内部信息。据泄露的 Teams 消息显示,Walmart 正准备在 AI 领域大展拳脚,并与 Microsoft 紧密合作。一位 Walmart 的 AI 工程师在聊天中表示:“Microsoft 在 AI 安全方面远远领先于 Google。我们很高兴与你们一起走这条路。”

Walmart 是 Microsoft 最大的企业客户之一,已经在使用公司的 Azure OpenAI 服务进行部分 AI 工作。此次泄露事件无疑引发了业界的广泛关注。

Microsoft 尚未就此次抗议和 Teams 消息泄露事件发表评论。然而,这已是 Microsoft Build 会议第三次被抗议者打断。此前,一名巴勒斯坦技术工人和一名 Microsoft 员工分别在会议中打断了高管的讲话。

此次抗议发生在 Microsoft 宣布已进行内部审查并使用一家未具名的外部公司评估其技术在加沙战争中的使用后几天。Microsoft 表示,其与以色列国防部(IMOD)的关系“是作为标准商业关系构建的”,并且“没有发现任何证据表明 Microsoft 的 Azure 和 AI 技术或其他任何软件被用于伤害人们,或 IMOD 未能遵守我们的服务条款或 AI 行为准则。”

随着 AI 技术的快速发展,企业在推动技术创新的同时,也面临着日益严峻的伦理和安全挑战。此次事件不仅暴露了 Microsoft 在内部沟通和会议管理上的漏洞,也再次引发了关于科技公司在全球政治冲突中角色的深刻讨论。