共计 1587 个字符,预计需要花费 4 分钟才能阅读完成。

2024 年 10 月 24 日 11:57 AM

来源:VentureBeat,由 Midjourney 制作

Meta Platforms 近日推出了其 Llama 人工智能模型的小型版本,这些版本专为智能手机和平板电脑设计,标志着 AI 技术向移动设备迈出了重要一步。

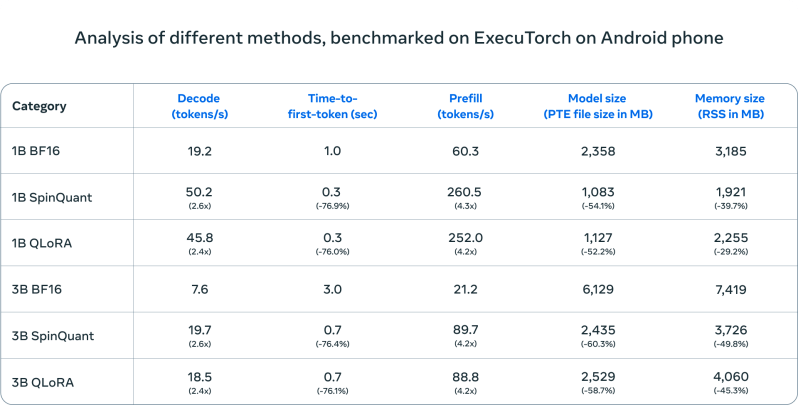

该公司宣布了 Llama 3.2 1B 和 3B 模型的压缩版本,这些版本不仅运行速度提高了四倍,而且内存使用量仅为早期版本的一半。根据 Meta 的测试,这些小型模型的性能几乎与大型版本相当。

这一技术突破使用了名为量化的压缩技术,简化了 AI 模型的数学计算。Meta 结合了两种方法:QLoRA 以保持准确性,以及 SpinQuant 以提高便携性。

这一创新解决了在没有大量计算能力的情况下运行高级 AI 的关键问题。以往,复杂的 AI 模型需要依赖数据中心和专用硬件。

在 OnePlus 12 Android 手机上的测试显示,压缩模型体积缩小了 56%,内存使用减少了 41%,同时处理文本的速度提高了两倍以上。这些模型可以处理长达 8000 个字符的文本,足以满足大多数移动应用的需求。

Meta 的压缩 AI 模型在 Android 手机上测试时,与标准版本相比,速度和效率显著提升。小型模型运行速度提高了四倍,同时内存使用量减少了一半。(来源:Meta)

科技巨头竞相定义 AI 的移动未来

Meta 的这一发布加剧了科技巨头之间的一场战略争夺战,即如何控制 AI 在移动设备上的运行。虽然 Google 和 Apple 对移动 AI 采取了谨慎、控制的方法,将其紧密集成到他们的操作系统中,但 Meta 的策略明显不同。

通过开源这些压缩模型并与芯片制造商 Qualcomm 和 MediaTek 合作,Meta 绕过了传统的平台守门人。开发者可以在不等待 Google 的 Android 更新或 Apple 的 iOS 功能发布的情况下构建 AI 应用。这一举措呼应了移动应用早期,开放平台显著加速创新的时代。

与 Qualcomm 和 MediaTek 的合作尤为重要。这些公司为全球大多数 Android 手机提供动力,包括新兴市场中的设备,Meta 在这些市场中看到了增长潜力。通过优化其模型以适应这些广泛使用的处理器,Meta 确保其 AI 可以在不同价格点的手机上高效运行——而不仅仅是高端设备。

通过 Meta 的 Llama 网站和 Hugging Face(一个日益有影响力的 AI 模型中心)进行分发,显示了 Meta 致力于在开发者已经工作的地方接触他们。这种双重分发策略可能有助于 Meta 的压缩模型成为移动 AI 开发的实际标准,就像 TensorFlow 和 PyTorch 成为机器学习标准一样。

AI 在你口袋中的未来

Meta 今天的宣布指向了人工智能的一个更大转变:从集中计算到个人计算的转变。虽然基于云的 AI 将继续处理复杂任务,但这些新模型预示着一个未来,手机可以私密且快速地处理敏感信息。

时机至关重要。科技公司面临着越来越大的数据收集和 AI 透明度压力。Meta 的方法——使这些工具开放并在手机上直接运行——解决了这两个问题。你的手机,而不是远端服务器,可能很快就会处理文档摘要、文本分析和创意写作等任务。

这反映了计算领域的其他关键转变。正如处理能力从大型机转移到个人电脑,计算从桌面转移到智能手机一样,AI 似乎准备迎来其向个人设备的转变。Meta 的赌注是,开发者将拥抱这一变化,创建结合了移动应用便利性和 AI 智能的应用程序。

成功并非保证。这些模型仍然需要强大的手机才能良好运行。开发者必须在隐私的好处与云计算的强大能力之间权衡。而 Meta 的竞争对手,特别是 Apple 和 Google,对 AI 在手机上的未来有自己的愿景。

但有一件事是明确的:AI 正在逐步摆脱数据中心的束缚,逐步向每部手机普及。

总的来说,Meta 的这一创新不仅为移动设备带来了更高效的 AI 解决方案,也为整个行业的发展指明了新的方向。随着技术的不断进步,我们有理由相信,未来的 AI 将更加智能、便捷,且无处不在。