共计 3643 个字符,预计需要花费 10 分钟才能阅读完成。

在 M1 Mac 上体验本地 AI,过程堪称残酷——原因如下。使用 Ollama 进行的这次实验并不轻松,反而给我上了一堂深刻的实践课。

ZDNET Tiernan Ray 截图。作为一名报道人工智能领域超过十年的记者,我深知运行 AI 模型会面临各种计算机工程挑战。其中一个核心原因是,大型语言模型变得越来越大,需要越来越多的 DRAM 内存来承载其模型“参数”或“神经权重”。尽管对此有所了解,我仍希望亲身体验一下——在自己的家用电脑上运行一个大型语言模型。

下载和运行 AI 模型通常需要大量工作来搭建“环境”。受同事 Jack Wallen 对开源工具 Ollama 报道的启发,我下载了 Ollama 的 MacOS 二进制文件,将其作为接触本地 AI 的入口。Ollama 相对易于使用,并且在集成 LangChain、Codex 等方面做得不错,这意味着它正逐渐成为一个能整合 AI 多方面功能的工具,这一点令人兴奋。

选择本地运行的理由

在本地运行 LLM,而不仅仅是在线使用 ChatGPT 或 Perplexity,对程序员乃至任何信息工作者都具有很大吸引力。

首先,作为信息工作者,如果能够下载并运行模型,而不仅仅是像 ChatGPT 普通免费用户那样在线输入提示词,在就业市场上会更具竞争力。这属于基本的职业发展能力。

其次,通过本地运行的 LLM 实例,可以确保敏感数据不会离开本地机器。这对任何信息工作者——不仅仅是程序员——都至关重要。以个人项目为例:我希望利用本地模型分析自己多年积累的文章库,生成一份关于个人写作内容的报告,其中可能包括一些被遗忘的片段。将所有文件保留在本地,而不是上传到云端,这个想法很有吸引力。

第三,可以避免 OpenAI、Google、Anthropic 等公司收取的使用费用。正如近期行业趋势所示,在线使用 LLM 的成本预计将上涨,因此现在正是考虑在本地机器上离线完成大部分工作的好时机——毕竟本地运行不会持续产生计费。

第四,用户拥有更多控制权。例如,如果需要进行编程,可以对 LLM 进行微调以获得更聚焦的结果;还可以使用各种本地安装的工具,如 LangChain、Anthropic 的 Claude Code 工具、OpenAI 的 Codex 编码工具等。即使只是执行信息工作者的常规任务,比如生成报告,使用本地文档缓存或本地数据库进行操作,也比把内容上传到在线机器人拥有更大的自主权。

在最低配置硬件上尝试

这次实验是在一台仅满足 LLM 运行最低要求的机器上进行的。我的目的是探究:如果一个不常更换电脑的人,尝试在他们日常使用的同一台家用电脑上运行 LLM,会发生什么。

我使用的 MacBook Pro 已有三年历史,配备 16GB 内存和 1TB 硬盘(已使用约四分之三空间),运行的不是最新版 MacOS,而是 MacOS Sonoma。这是 2021 年款,型号 MK193LL/A。虽然在 2023 年 1 月百思买清仓促销中购买时它仍是顶级配置,但那时它已开始显得过时。

当然,这台电脑已经超出了典型的更新周期和折旧计划。尽管如此,这台 MacBook 在当时是一次重大升级,在日常信息处理任务中一直表现出色:处理日历、大量电子邮件、浏览网页、视频后期制作、播客音频录制等等。我从未有过抱怨。毕竟,如果没坏,就不用修,对吧?问题是:这台老旧但仍算强大的机器,将如何应对这种截然不同的新型工作负载?

启动 Ollama

ZDNET Tiernan Ray 截图。Ollama 的启动界面看起来很像 ChatGPT:一个友好的输入提示框、一个用于上传文档的“加号”按钮,以及一个可本地安装的模型下拉菜单,其中包括 Qwen 等流行模型。

如果直接在提示框输入,Ollama 会自动尝试下载下拉菜单中当前显示的模型。因此,除非你想玩“模型轮盘赌”,否则不要随意输入。我仔细查看了下拉列表,发现其中一些模型并非本地运行——它们位于云端。Ollama 提供云服务,用户可以选择使用其基础设施而非自己的硬件。当需要使用会过度消耗本地资源的大型模型时,这很有用。

根据定价页面,Ollama 在免费账户中提供一定的云访问权限;“Pro”计划每月 20 美元可运行多个云模型;“Max”计划每月 100 美元则提供更多使用量。我坚持选择本地运行选项,并决定查看 Ollama 维护的模型目录中更广泛的列表。

我随机选择了来自中国 AI 初创公司 Z.ai 的 glm-4.7-flash。该模型拥有 300 亿个“参数”或神经权重。按照今天的标准,GLM-4.7-flash 属于“小型”大型语言模型,但并非微小——毕竟还有参数少于 10 亿的开源模型。(就在不久前,10 亿参数已经算是很大了!)目录提供了从 Mac 终端下载所选模型的命令,只需在提示符处复制粘贴即可,例如:ollama run glm-4.7-flash。

需要注意磁盘空间。Glm-4.7-flash 占用 19GB 的磁盘空间——请记住, 这还算小的! 根据我的经验,下载模型的速度似乎相当快,虽然不是闪电般迅速。在纽约市 Spectrum 提供的千兆速度有线调制解调器网络环境下,模型下载速度一度达到每秒 45 兆字节,但后来吞吐量下降到了较慢的水平。

初步了解模型

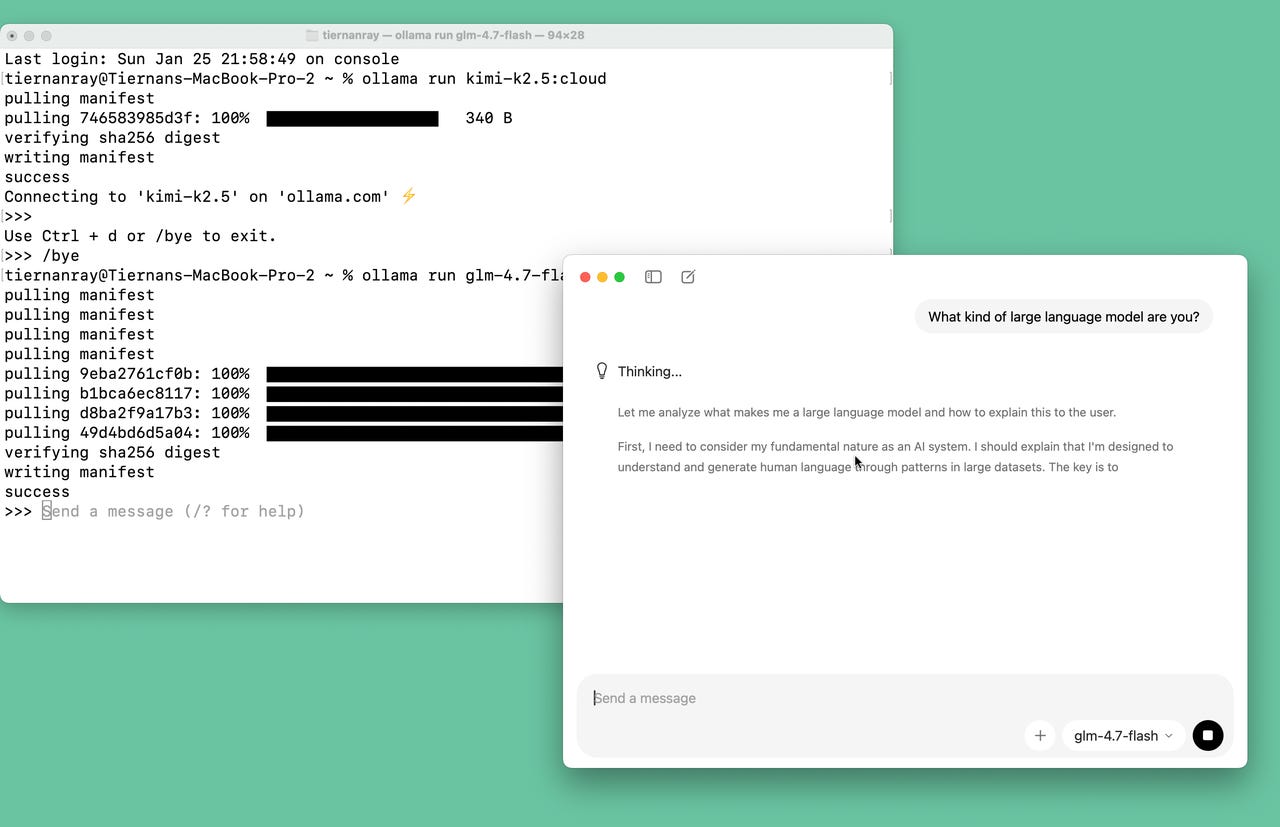

第一个提示词相当简单:“你是哪种大型语言模型?”我坐着观察了一会儿,响应中逐渐出现了最初的几个字符:“[灯泡图标] 思考中——让我分析一下是什么让我成为一个”,然后就没有下文了。十分钟后,进展依然不大。

让我分析一下是什么让我成为一个大型语言模型,以及如何向用户解释这一点。

首先,我需要考虑我作为一个 AI 系统的基本性质。我应该解释我是通过大型数据集中的模式来理解和生成人类语言的。关键是要清晰

此时,Mac 上的所有操作都变得明显迟缓。四十五分钟后,glm-4.7-flash 仍在产生关于思考的思考:“让我组织一下这个解释,首先明确说明……”,诸如此类。

陷入提示词蔓延的困境

一小时十六分钟后——模型“思考”了 5,197.3 秒——我终于得到了关于 glm-4.7-flash 是何种语言模型的查询答案。花费了这么多时间,答案本身却并不那么有趣。它没有透露太多关于 glm 的、无法自行推断的信息,也没有说明 glm 与其他大型语言模型之间的显著差异:

ZDNET Tiernan Ray 截图。我认为此时已经完成了对 glm 的测试。不幸的是,Ollama 没有提供关于如何在本地安装后删除模型的说明。模型保存在 MacOS 当前用户目录下的隐藏文件夹“.ollama”中,里面还有一个名为“models”的文件夹。models 文件夹内有两个子文件夹:“blobs”和“manifests”。模型的大部分内容位于 blobs 文件夹中。manifests 内有一个“library”文件夹,其中包含以每个已下载模型命名的文件夹,里面还有一个“latest”文件夹。我使用终端,删除了 blobs 文件夹的内容,并删除了每个模型文件夹的内容,从而解决了这个问题。

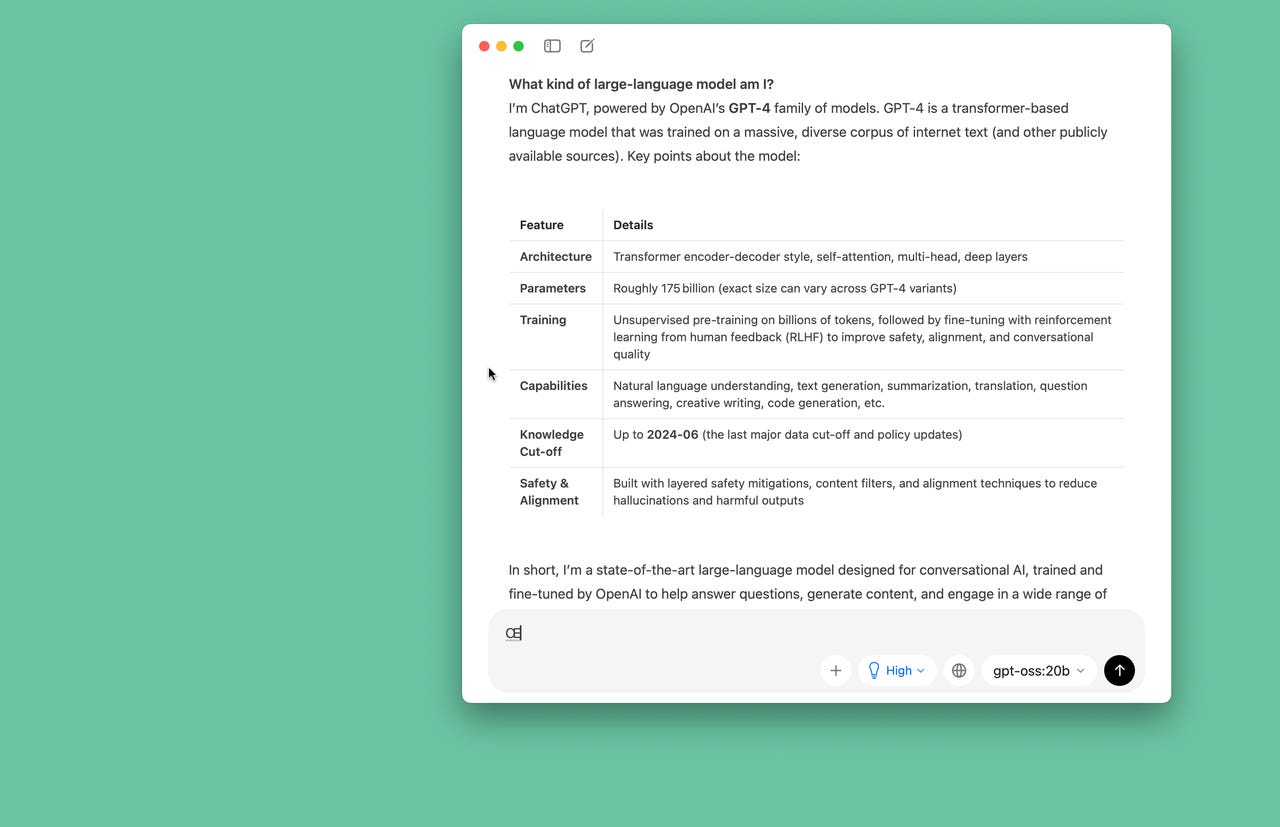

Jack 还推荐了 OpenAI 最近的开源模型 gpt-oss,参数规模为 200 亿的“20b”版本,他表示该版本在本地运行速度明显快于他尝试过的其他模型。因此,我接下来在目录中找到了这个模型。这一次,大约六分钟后,gpt-oss:20b 以不算蜗牛般缓慢但也不快的速度产生了响应,称自己是“由 OpenAI 的 GPT- 4 系列驱动的 ChatGPT”等等。这个响应后面附有一个不错的详细信息表格。(奇怪的是,gpt-oss:20b 告诉我它拥有“大约 1750 亿参数”,这表明 gpt-oss:20b 并不完全清楚自己 20b 的身份。)

无论如何,这对于一个简单的提示词来说还可以接受。但已经很清楚地意识到,任何更有雄心的尝试都会遇到问题。等待回复的感觉足够缓慢——可以称之为一种“提示词蔓延”——以至于我不敢尝试增加任何复杂性,例如上传整个写作库。

我们需要一台更新的机器

OpenAI 实际的 ChatGPT 在线服务(运行 GPT5.2)告知,运行 gpt-oss:20b 的计算机最低配置实际上是 32GB DRAM。我的 MacBook 搭载 M1 Pro 芯片,集成了 GPU。ChatGPT 赞许地指出,Ollama 提供的 gpt-oss:20b 版本支持 Mac GPU,这得益于一个被称为“llama.cpp 后端”的库。

所以,理论上一切应该没问题,但确实需要超过 16GB 的 DRAM。并且需要从已有五年历史的 M1 升级到 M4 或 M5。拥有三十年计算机写作经验,对于信息工作者来说,32GB 被讨论为最低合理配置,这相当引人深思。

正如最近提到的,由于所有那些云数据中心为了运行大型语言模型而消耗越来越多的 DRAM,DRAM 价格正在飙升。可以说,这是个人与云供应商之间的对抗,而我很可能需要动用信用卡来升级到一台新电脑。(苹果公司提供的以旧换新价格约为 599 美元,用于换购 M1 MacBook。)

虽然这次初步的本地 Ollama 尝试并未取得成功,但它让我对 AI 的内存密集程度有了新的认识。多年来报道 AI,我一直知道这一点,但现在切身体会到了——当提示词的响应在屏幕上缓慢滚动时,那种感觉是如此真切。