共计 2005 个字符,预计需要花费 6 分钟才能阅读完成。

Liquid AI,一家由麻省理工学院(MIT)计算机科学与人工智能实验室(CSAIL)前研究人员共同创立的初创公司,近日宣布了其首个多模态 AI 模型的首次亮相:“Liquid Foundation Models (LFMs)”。

与当前生成式 AI 浪潮中的大多数模型不同,这些模型并非基于 2017 年经典论文“Attention Is All You Need”中概述的 transformer 架构。相反,Liquid 的目标是“探索超越生成式预训练 Transformer(GPT)的基础模型构建方法”,并通过新的 LFMs,特别是从“第一原理…工程师构建引擎、汽车和飞机的方式”出发。

他们似乎已经做到了这一点——因为新的 LFM 模型已经在性能上超越了其他类似规模的基于 transformer 的模型,如 Meta 的 Llama 3.1-8B 和微软的 Phi-3.5 3.8B。

Liquid 的 LFMs 目前有三种不同的大小和变体:

- LFM 1.3B(最小)

- LFM 3B

- LFM 40B MoE(最大,类似于 Mistral 的 Mixtral 的“专家混合”模型)

它们名称中的“B”代表十亿,指的是模型的参数数量——或设置——这些参数控制着模型的信息处理、分析和输出生成。一般来说,参数数量越多的模型在更广泛的任务中表现越出色。

Liquid AI 表示,LFM 1.3B 版本已经在许多领先的第三方基准测试中超越了 Meta 的新 Llama 3.2-1.2B 和微软的 Phi-1.5,包括流行的涵盖科学、技术、工程和数学(STEM)领域的 57 个问题的 Massive Multitask Language Understanding (MMLU),“这是非 GPT 架构首次显著超越基于 transformer 的模型。”

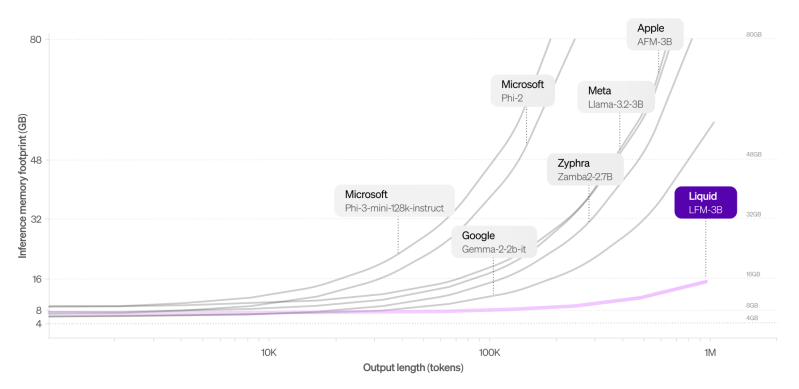

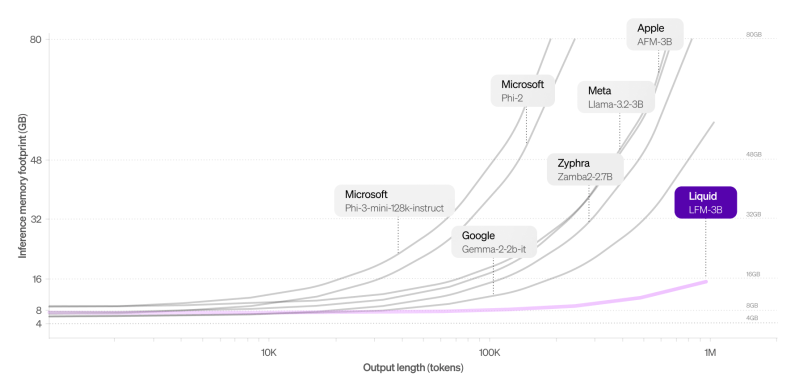

所有三种模型都旨在提供最先进的性能,同时优化内存效率,Liquid 的 LFM-3B 仅需 16 GB 内存,而 Meta 的 Llama-3.2-3B 模型则需要超过 48 GB 内存。

Liquid AI 的训练后负责人 Maxime Labonne 在 X 平台上的账户上表示,LFMs 是“我职业生涯中最自豪的发布 :)”,并澄清了 LFMs 的核心优势:它们能够在使用显著较少内存的情况下超越基于 transformer 的模型。

这些模型不仅在原始性能基准上具有竞争力,而且在操作效率方面也表现出色,使其适用于从金融服务业、生物技术和消费电子等企业级应用到边缘设备部署的各种用例。

然而,对于潜在用户和客户来说,重要的是这些模型并非开源。用户需要通过 Liquid 的推理游乐场、Lambda Chat 或 Perplexity AI 访问它们。

在这种情况下,Liquid 表示它使用了“深深植根于动力系统理论、信号处理和数值线性代数计算单元的混合”,结果是“通用 AI 模型,可用于建模任何类型的序列数据,包括视频、音频、文本、时间序列和信号”,以训练其新的 LFMs。

去年,VentureBeat 报道了更多关于 Liquid 训练后 transformer AI 模型的方法,当时指出它正在使用 Liquid 神经网络(LNNs),这是一种由 CSAIL 开发的架构,旨在使人工“神经元”或数据转换节点更加高效和适应性强。

与需要成千上万神经元执行复杂任务的传统深度学习模型不同,LNNs 展示了通过创新的数学公式结合较少的神经元可以实现相同的结果。

Liquid AI 的新模型保留了这种适应性的核心优势,允许在推理过程中进行实时调整,而不会产生与传统模型相关的计算开销,高效处理多达 100 万个 token,同时将内存使用保持在最低限度。

当其他模型在长上下文处理时内存使用急剧增加时,LFM-3B 保持了显著较小的占用空间,使其非常适合需要大量序列数据处理的应用,如文档分析或聊天机器人。

Liquid AI 构建了其基础模型,使其能够跨多种数据模态(包括音频、视频和文本)进行多功能应用。通过这种多模态能力,Liquid 旨在解决从金融服务到生物技术和消费电子等行业的广泛特定挑战。

Liquid AI 表示,它正在优化其模型以部署在 NVIDIA、AMD、Apple、Qualcomm 和 Cerebras 的硬件上。虽然这些模型仍处于预览阶段,但 Liquid AI 邀请早期采用者和开发者测试这些模型并提供反馈。

Labonne 指出,虽然“还不完美”,但在此阶段收到的反馈将帮助团队在 2024 年 10 月 23 日在麻省理工学院的 Kresge 礼堂举行的全面启动活动前完善他们的产品。公司正在接受现场活动参与者的 RSVP。

作为其透明度和科学进步承诺的一部分,Liquid 表示将在产品发布活动前发布一系列技术博客文章。公司还计划进行红队测试,鼓励用户测试其模型的极限,以改进未来的迭代。

随着 Liquid Foundation Models 的推出,Liquid AI 将自己定位为基础模型领域的关键参与者。通过结合最先进的性能和前所未有的内存效率,LFMs 为传统基于 transformer 的模型提供了一个引人注目的替代方案。