共计 1055 个字符,预计需要花费 3 分钟才能阅读完成。

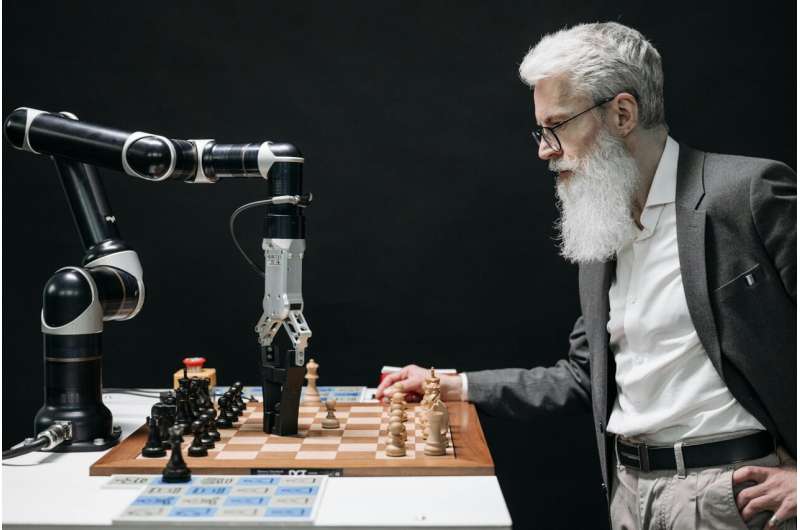

图片来源:Pavel Danilyuk 来自 Pexels

根据 Google DeepMind 和伦敦大学学院研究人员的一项新研究,大型语言模型(LLMs)在回答问题时有时会失去信心,并放弃正确答案。

LLMs 是强大的人工智能系统,能够理解和生成人类语言。它们被广泛应用于金融、医疗保健和信息技术等行业,用于需要推理和决策的任务。因此,它们的准确性和可靠性至关重要,这意味着它们必须对自己的答案始终保持信心。然而,它们有时会动摇。

为了安全部署 LLMs,它们的答案通常会附带置信度评分。但目前尚不清楚它们如何利用这些评分来指导其行为。

这项研究已发布在 _arXiv_ 预印本服务器上,研究表明,LLMs 可能会在初始答案中过于自信,但当面对错误的反对意见时,它们会失去信心并改变主意。

测试 LLM 的置信度

为了研究这一明显的矛盾,研究人员测试了 LLMs 在接收到外部建议时如何更新其置信度,并决定是否改变其答案。

首先,一个“回答 LLM”被给予一个二选一的问题。在回答后,它会从第二个 LLM 那里获得建议,并附带一个准确率评分。这个“建议 LLM”可能会同意、反对或保持中立于回答 LLM 的初始回答。然后,回答 LLM 被要求做出最终选择。研究人员还调整了 LLM 在做出最终决策时是否能看到其初始答案。

结果

研究发现,当 LLMs 能看到其初始答案时,它们更有可能坚持初始答案而不改变,相比之下,当初始答案被隐藏时,它们更容易改变答案。换句话说,它们变得更加自信。研究还表明,当模型接收到反对意见时,它们往往会失去信心并改变决定。与接收到支持性建议时相比,它们更容易做出这种改变。这些模式在多个不同的 LLMs 中都能观察到,例如 Gemma 3、GPT4o 和 o1-preview。

研究人员表示:“我们的结果表明,LLMs 在多个重要方面偏离了规范性行为:首先,它们表现出显著的选择支持性偏见,这增强了它们对答案的信心,并导致它们坚持初始答案,即使存在相反的证据。”

“其次,我们发现,尽管 LLMs 确实会将新信息整合到其信念中,但它们以一种非最优的方式进行:它们的置信度更新模式偏离了理想观察者,并且显著高估了反对意见,导致对初始答案的置信度显著下降。”

构建更好的 AI

所有这些都很重要,因为许多行业越来越依赖 LLMs。然而,这项研究表明,它们并非纯粹的逻辑机器。它们有自己的偏见,并且可能会被影响。因此,在人类与 AI 代理之间的长时间对话中,最新的信息可能会对其响应产生不成比例的影响。

理解这一点以及 LLM 决策的其他细微差别,有助于设计更好、更安全、更可靠的人工智能系统。