共计 1365 个字符,预计需要花费 4 分钟才能阅读完成。

如果你对 DeepSeek 感到好奇,但又担心隐私问题,以下两种方法或许能为你提供解决方案。

DeepSeek 是当前人工智能领域的热门话题。作为一家成立于 2023 年 5 月的中国 AI 初创公司,DeepSeek 以独立 AI 研究实验室的身份运作,并因开发出功能强大且成本远低于美国同类产品的大型语言模型(LLMs)而备受全球关注。

DeepSeek 采用开源模式,这也是其成本较低的原因之一。该公司声称其开发 LLMs 的成本远低于美国 AI 公司。DeepSeek 模型的表现不逊于(甚至优于)其他模型,并且针对不同用途(如编程、通用和视觉)发布了多种模型。

使用 DeepSeek 的体验颇为有趣。DeepSeek 在向用户传递信息的过程中,似乎总是在与自己对话。其回答通常较为冗长,可能引导用户深入多个不同领域,每个领域都能带来新的知识。

如果你对 DeepSeek 感兴趣,无需依赖第三方即可使用。用户可以在本地安装 DeepSeek 并随时使用。

如何将 DeepSeek 添加到 Msty

所需条件:需要安装 Ollama 和 Msty。该方法适用于 Linux、MacOS 或 Windows,且完全免费。

- 打开 Msty

第一步是打开 Msty 图形用户界面。具体操作取决于所使用的操作系统。 - 访问本地 AI 模型部分

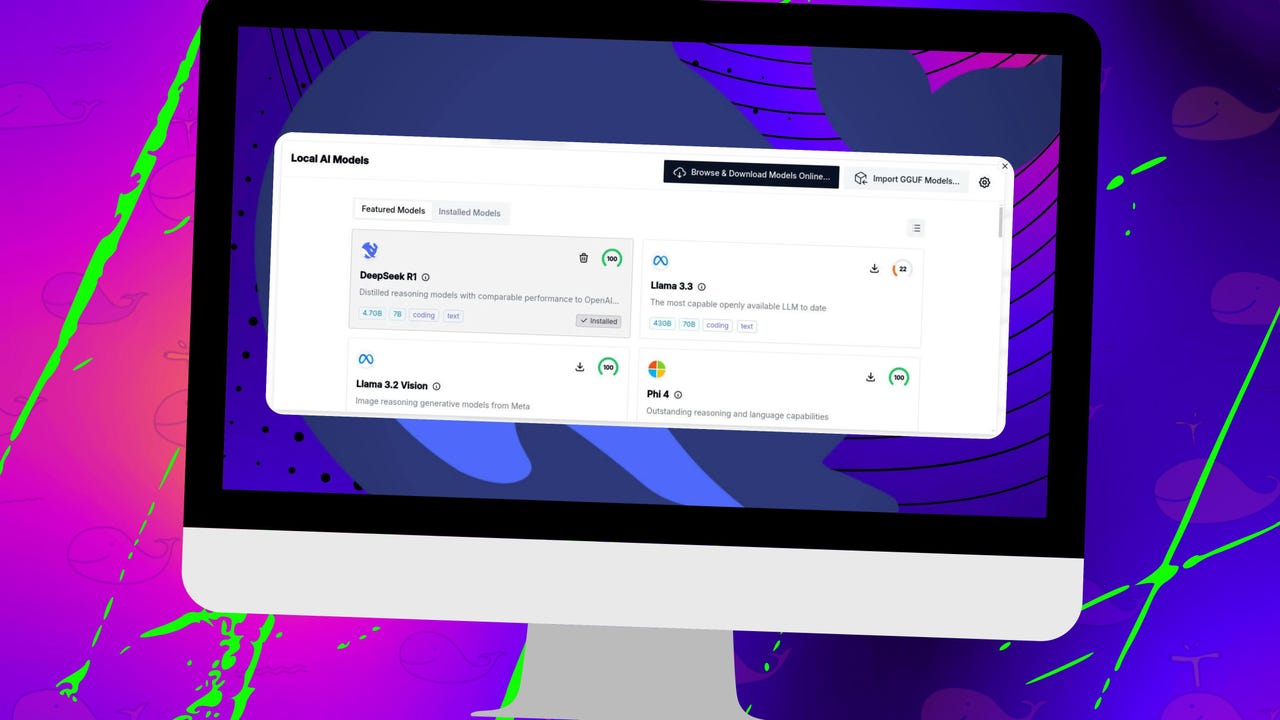

在左侧边栏中,点击形如带有闪电标志的电脑显示器图标,以打开本地 AI 模型部分。 - 安装 DeepSeek

在本地 AI 模型部分,找到 DeepSeek R1。点击下载按钮(向下箭头)将 DeepSeek 模型添加到 Msty。下载完成后,关闭本地 AI 模型窗口。 - 选择并使用 DeepSeek

返回主窗口,点击模型选择下拉菜单,选择 DeepSeek R1(位于本地 AI 下),然后输入查询内容。

如何通过 Linux 命令行在本地安装 DeepSeek

另一种选择是在 Linux 上完全安装 DeepSeek。在开始之前,需了解该系统要求较高,至少需要以下配置:

- CPU:建议使用至少 12 核的强大多核处理器。

- GPU:支持 CUDA 的 NVIDIA GPU 以加速性能。如果 Ollama 未检测到 NVIDIA GPU,将配置为仅使用 CPU 模式运行。

- 内存:至少 16 GB,建议 32 GB 或更多。

- 存储:建议使用 NVMe 存储以实现更快的读写操作。

- 操作系统:需要 Ubuntu 或基于 Ubuntu 的发行版。

如果系统满足上述要求,并且已安装 Ollama,可以通过以下命令运行 DeepSeek R1 模型:

ollama run deepseek-r1:8b

如果尚未安装 Ollama,可通过以下命令完成安装:

curl -fsSL https://ollama.com/install.sh | sh

系统将提示输入用户密码。

还可运行其他版本的 DeepSeek,包括:

ollama run deepseek-r1– 默认的 8B 版本ollama run deepseek-r1:1.5b– 最小模型ollama run deepseek-r1:7b– 7B 版本ollama run deepseek-r1:14b– 14B 版本ollama run deepseek-r1:32b– 32B 版本ollama run deepseek-r1:70b– 最大且最智能的模型

命令完成后,将进入 Ollama 提示符,用户可开始使用所选模型。

无论选择哪种方式,用户现在都可以访问 DeepSeek AI,并在本地机器上安全地使用所有查询和信息。