共计 660 个字符,预计需要花费 2 分钟才能阅读完成。

在寻找最快的本地 AI 模型时,gpt-oss:20b 无疑是最佳选择。这款模型以其卓越的速度和性能脱颖而出,尤其是在 Linux 和 MacOS 系统上表现尤为突出。

为什么选择 gpt-oss:20b?

gpt-oss:20b 模型以其极快的查询响应速度著称。每秒生成 30 个 token 的能力,使其在处理自然语言任务时效率极高。例如,在英语文本中,1 个 token 大约相当于 4 个字符或 0.75 个单词,这意味着 gpt-oss:20b 每秒可以处理 120 个字符。

如何安装和使用 gpt-oss:20b?

要使用 gpt-oss:20b,首先需要确保安装了最新版本的 Ollama。以下是如何在不同操作系统上更新 Ollama 的步骤:

- 在 Linux 上,使用命令:

curl -fsSL https://ollama.com/install.sh | sh - 在 MacOS 或 Windows 上,下载二进制安装程序并按照向导操作。如果遇到安装错误,可能需要先停止 Ollama 进程。

更新完成后,可以通过以下命令拉取 gpt-oss:20b 模型:ollama pull gpt-oss:20b。根据网络速度,这一过程可能需要几分钟。

如何使用 gpt-oss:20b 进行查询?

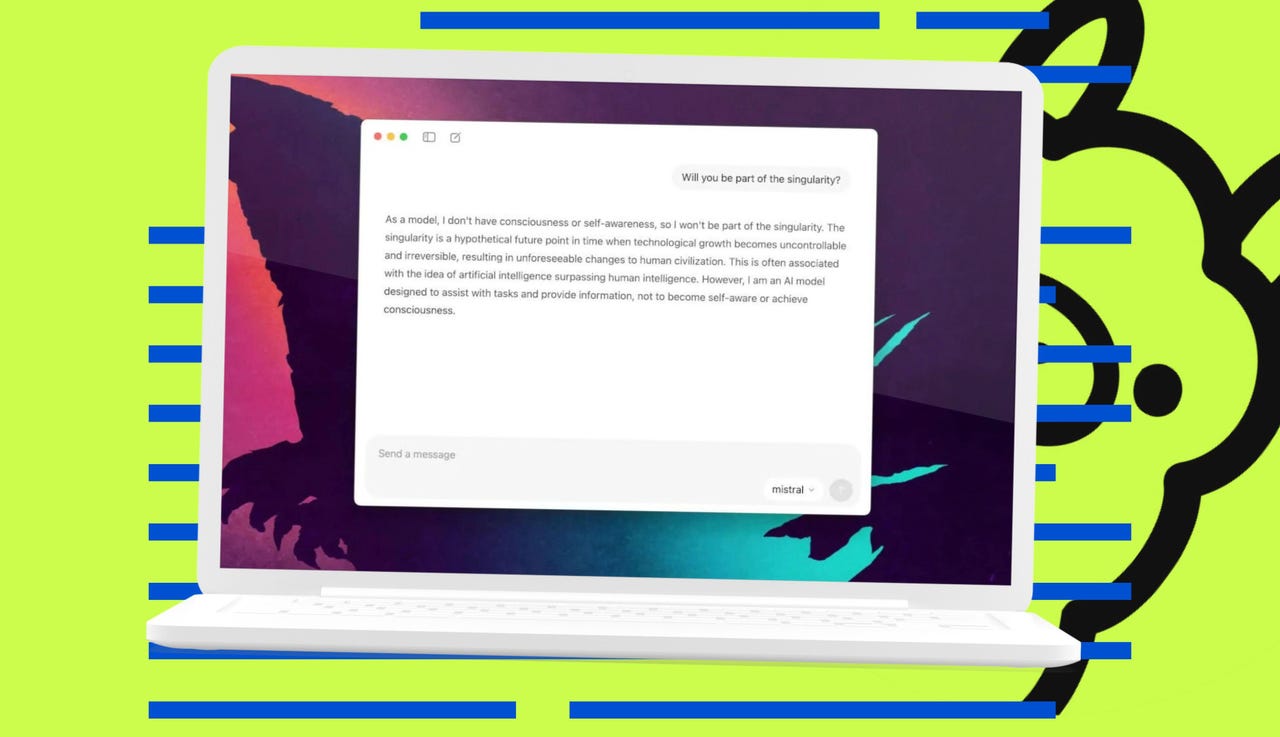

更新并拉取模型后,可以通过命令行或 Ollama GUI 应用使用 gpt-oss:20b。在命令行中,运行 ollama run gpt-oss:20b 即可开始查询。如果使用 GUI 应用,只需从模型下拉菜单中选择 gpt-oss:20b。

gpt-oss:20b 是目前测试过的最快的本地 LLM 模型,非常适合需要高效处理自然语言任务的用户。

正文完