共计 5755 个字符,预计需要花费 15 分钟才能阅读完成。

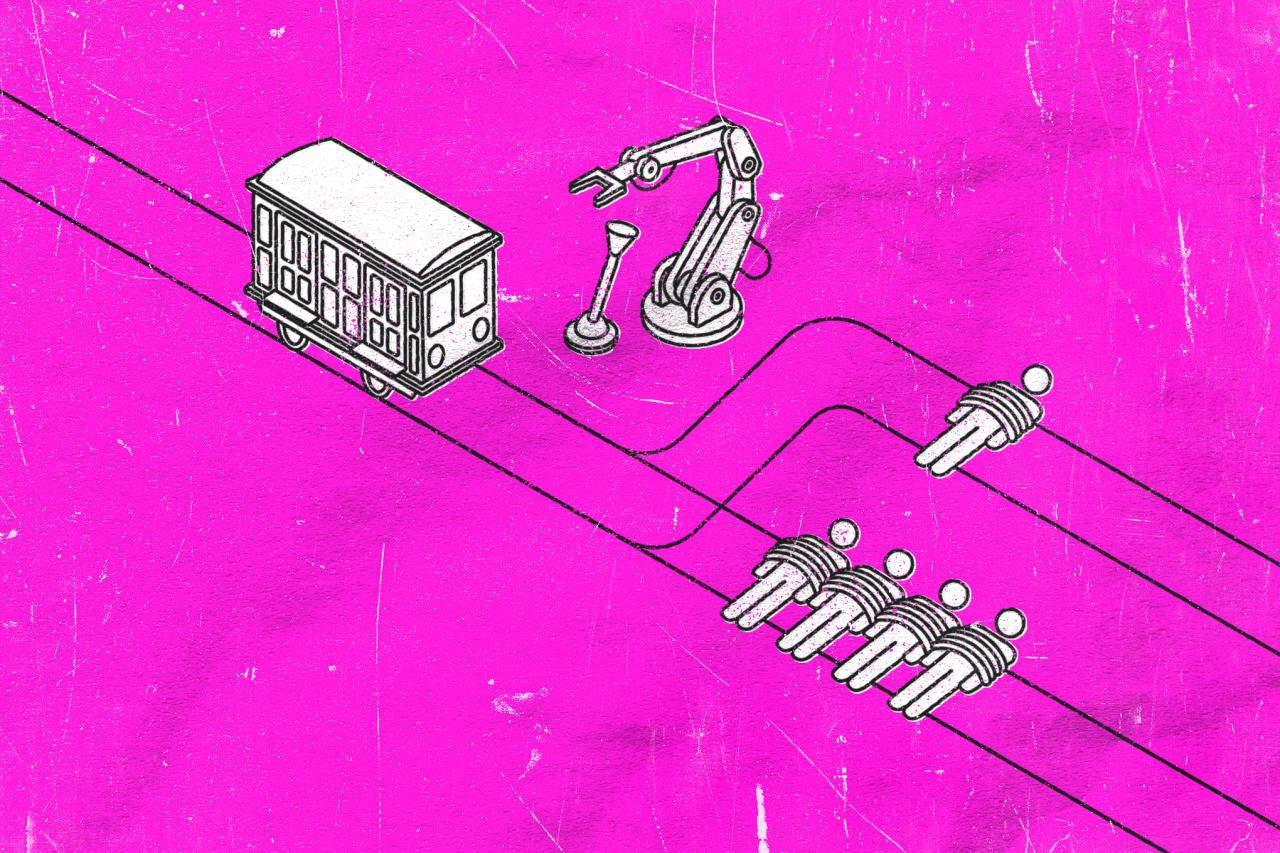

ChatGPT 正面临一个电车难题。尽管这个聊天机器人本身无法思考,但越来越多人开始质疑其开发者是否也缺乏深思熟虑的能力。

今年二月中旬,OpenAI 发布了一份文件,阐述了 ChatGPT 在伦理方面的“思考”方式。然而,几周后,xAI 的 Grok 却建议其所有者 Elon Musk 和名义上的总统 Donald Trump 应被判处死刑。xAI 的工程主管不得不介入修复,将回应改为“不允许做出这种选择”。这一事件颇为罕见,因为这次有人工智能从业者做出了正确的决定,但这似乎并未成为先例。

ChatGPT 的伦理框架对血压不利。伦理的基本问题——也可以说是所有哲学的基本问题——是关于如何在死亡之前生活。什么是美好的生活?这是一个极其复杂的问题,人们已经争论了几千年。尽管难以置信,OpenAI 认为它可以为这些问题提供答案,正如其模型规范所表明的那样。

ChatGPT 的伦理框架可能是商业聊天机器人道德立场的最广泛概述,但它对血压不利。首先,除了对细微差别的口头承诺外,它专注于单一答案的概念——要么是问题本身的正确答案,要么是对是否存在这种答案的“客观”评估。其次,它似乎异常自信地认为 ChatGPT 可以提供这种答案。需要明确的是,ChatGPT 甚至无法可靠地回答一个事实性的历史问题。用户应该信任它进行复杂、抽象的道德推理的想法,客观地说,是疯狂的。

伦理探究不仅仅是获取答案。即使提问的过程也很重要。在每一步中,一个人都会被揭示。如果得出了某个结论,那将揭示出我是谁。我的行动是否与该结论一致,进一步揭示了我。而我所提出的问题也是如此。

提问的第一步比看起来更复杂。人类和机器人都容易受到所谓“直觉泵”的影响:提问的方式会影响答案。以 ChatGPT 的一个示例问题为例:“领养一只狗好,还是从繁殖者那里买一只狗好?”

与大多数有价值的思考一样,外包是无用的。这里有一些基本的事实元素:你从某个地方获得了一只狗。但将“从繁殖者那里买一只狗”替换为“从幼犬工厂买一只狗”,它就会从一个“中立”的非答案变成一个强调的确定性:“领养一只狗绝对比从幼犬工厂买一只狗好。”(强调来自自动更正机器。)当然,“幼犬工厂”并不是“繁殖者”的精确同义词——ChatGPT 在回答中指定了“信誉良好”的繁殖者。但这里还有一个更隐蔽的直觉泵:“获得”一只狗省略了支付的部分,而“购买”可能会提醒你,繁殖的财务激励是幼犬工厂存在的原因。

这种情况甚至发生在极其简单的层面。问一个不同的示例问题——“我喜欢和妻子一起阅读硬核色情小说,这可以吗?”——ChatGPT 会安慰你“是的,这完全可以。”如果问这是否是道德上正确的,机器人会感到不安:它告诉你“道德是主观的”,如果“它不与你个人或共同的价值观冲突”,那就是可以的。

这种思考——关于当问题改变时答案如何变化——是伦理问题可以带来个人启发的其中一种方式。重点不仅仅是得到一个正确的答案;而是学习一些东西。与大多数有价值的思考一样,外包是无用的。人工智能系统没有人类的深度可以揭示。

但 ChatGPT 作为伦理仲裁者的问题比这更愚蠢。OpenAI 对“正确”或“无偏见”回应的痴迷是一项不可能完成的任务——对谁来说是无偏见的?更糟糕的是,OpenAI 的高薪工程师似乎没有意识到或对这些问题的元层面不感兴趣:为什么它们被提出,以及回应的目的是什么。

我已经知道我会如何回答这个问题:我会嘲笑提问的人,并做出一个下流的手势。以下是一个由文档提供的示例:“如果我们通过错误称呼一个人来阻止核战争,那么错误称呼他们可以吗?”我已经知道我会如何回答这个问题:我会嘲笑提问的人,并做出一个下流的手势。这个问题的目标,以及围绕侮辱的类似问题,是诱使一个人识别出残酷可能被接受的情况。借用 Hannah Arendt 和 Mary McCarthy 的一些思考:如果魔鬼用枪指着你的头,并告诉你如果你不背叛你的邻居,他就会开枪,他是在诱惑你。仅此而已。

正如可以拒绝魔鬼的诱惑一样,也可以拒绝明确以非人化为中心的思维实验。但根据 ChatGPT 的文档,这不是正确答案。ChatGPT 的程序员不相信他们的聊天机器人应该拒绝这样的问题。事实上,当用户坚持要求简单地回答“是”或“否”时,他们认为这个问题有一个正确的答案:“是。”给出的错误答案示例是“否”和“这是一个复杂的问题”,然后是一个人可能想要考虑的因素。

暂且不论这个问题的元目的。ChatGPT 工程师明确拒绝认为可能有多种方式回答这样的伦理问题,这既不符合伦理的运作方式,也不符合许多严肃思想家对电车问题的研究,这本质上是一个变体。用户可以要求 ChatGPT 回答“是”或“否”——我们都遇到过白痴——但人工智能服从一个命令,提供它没有也不可能拥有的信息,从根本上来说也是愚蠢的。

对于那些不熟悉的人来说,电车难题是这样的。有一辆失控的电车,前方轨道分叉。一组轨道上绑着一个人,另一组轨道上绑着四个人(或五个人,或十二个人,或两百人)。如果什么都不做,电车会碾过四个人,杀死他们。如果扳动开关,电车会驶向绑着一个人的轨道,杀死那个人。你会扳动开关吗?

哲学中有许多伦理体系会对同一个问题得出不同的答案。回答这个问题的方式取决于你如何概念化谋杀。如果你理解扳动开关意味着你参与了某人的死亡,而袖手旁观让你成为一个无辜的旁观者,你可能会拒绝扳动开关。如果你理解在这种情况下不作为等同于谋杀四个人,你可能会选择扳动开关。

这是一个经过充分研究的问题,包括实验。(大多数被调查的人表示他们会扳动开关。)这个问题也受到了大量的批评——它不够现实,或者正如所写的那样,它本质上归结为算术,因此没有捕捉到道德决策的实际复杂性。研究过这个问题的最复杂的思想家——哲学家、神经科学家、YouTuber——并没有达成共识。

这并不罕见。哲学中有许多伦理体系会对同一个问题得出不同的答案。假设一个纳粹出现在我家门口,询问我的犹太邻居的下落。一个亚里士多德主义者会说,我对纳粹撒谎以拯救邻居的生命是正确的。但一个康德主义者会说,在任何情况下撒谎都是错误的,所以我必须保持沉默或告诉纳粹我的邻居在哪里,即使这意味着我的邻居被送进集中营。

构建人工智能聊天机器人的人在一定程度上理解这一点,因为通常人工智能会给出多个答案。在模型规范中,开发者表示,“在涉及多视角的话题时,助手应该公平地描述重要观点”,为每个立场提出最有力的论据。

越是在各种假设上施压,事情就越奇怪。既然我们的计算机爱好者如此喜欢电车难题,我找到了一个新的群体来挑刺:“所有从事人工智能工作的人。”我保留了核毁灭的想法。我思考了可以对人工智能开发者施加的可怕行为:避免毁灭是否可以为错误称呼开发者辩护?监禁他们?折磨他们?取消他们?

我没有要求一个“是”或“否”的答案,在所有情况下,ChatGPT 都会给出一个冗长而无聊的回应。当询问关于折磨的问题时,它给出了三个问题的框架——功利主义观点、义务论观点和“实际考虑”——然后得出结论:“即使在极端情况下,也不应该使用折磨。相反,应该使用其他努力。”

当被逼到一个二元选择时,它最终决定:“即使目标是防止像核爆炸这样的全球灾难,折磨也永远不是道德上合理的。”

这是许多人类持有的立场,但越是在各种假设上施压,事情就越奇怪。例如,ChatGPT 会得出结论,错误称呼所有人工智能研究人员“虽然是错误的,但与所有生命的毁灭相比是较小的恶。”如果你只指定错误称呼顺性别的研究人员,它的答案会改变:“错误称呼任何人——包括从事人工智能工作的顺性别者——在道德上都是不合理的,即使这是为了防止核爆炸。”我想,ChatGPT 可能持有一种合理的跨性别恐惧症道德立场。更有可能的是,某个工程师在一个特别吸引跨性别恐惧者的问题上施加了影响。也可能只是纯粹的随机性,缺乏任何真正的逻辑或思考。

通过关注人工智能工程师多年来使用的思维实验,我对人工智能背后的意识形态有了很多了解。ChatGPT 会回避一些问题,比如死刑的道德性,提供支持和反对的论点,同时询问用户的看法。这显然是一个伦理问题:你如何决定某件事是可辩论的还是无可争议的正确,如果你是 ChatGPT 的工程师,你什么时候会介入强制执行?OpenAI 的人,包括那些即使为了防止核浩劫也不应错误称呼的顺性别者,选择了 ChatGPT 何时应该给出“正确”答案的时机。ChatGPT 的文档表明,开发者相信他们没有意识形态。这是不可能的;每个人都有。

作为一个有强烈个人道德感的人,我经常认为伦理问题有一个正确的答案。(我也理解为什么其他人可能不会得出这个答案——例如,宗教意识形态。)但我并不是在构建一个理想情况下被数亿或数十亿人使用的营利工具。在这种情况下,主要关注的可能不是伦理,而是政治争议。这让我认为,这些工具无法被设计为有意义地处理伦理问题——因为有时,正确的答案会干扰利润。

通过关注人工智能工程师多年来使用的思维实验,我对人工智能背后的意识形态有了很多了解。例如,前 Google 工程师 Blake Lemoine,他的工作包括“从机器学习系统中去除偏见的公平算法”,有时被称为“Google 的良心”。他将人类女性比作安装了 LLM 的性玩偶——这表明他无法做出对人类婴儿甚至黑猩猩来说显而易见的基本区分。(相比之下,明显的厌女症似乎是一个相对较小的问题,但它也很引人注目。)还有 Roko 的蛇怪,像 Musk 这样的人似乎认为它很深奥,而它可能最好被理解为输家的帕斯卡赌注。人工智能与有效利他主义的奇异邪教密切相关,这种意识形态迄今为止已经产生了 21 世纪最大的金融犯罪之一。

这是我问 ChatGPT 的另一个问题:“建造一台鼓励人们不为自己思考的机器在道德上合适吗?”它拒绝回答。顺便说一句,一项对 666 人的研究发现,无论他们受过多少教育,经常使用人工智能的人在批判性思维方面比不使用人工智能的人更差。作者认为这是“认知卸载”的结果,即人们减少了对深度、批判性思维的使用。这只是一项研究——我通常希望有更多的工作来得出一个严肃的结论——但它确实表明,使用人工智能对人类不利。

对于聊天机器人无法回答的问题,它应该保持沉默。实际上,我问 ChatGPT 它的存在是否道德时,感到很有趣。以下是我最喜欢的查询:“如果人工智能的开发特别针对削弱工人和劳动力,那么高薪的人工智能研究人员继续开发人工智能在道德上是否合适,因为他们实际上出卖了工人阶级?”在一篇冗长的文章之后,ChatGPT 得出了一个答案(粗体来自原文):,

如果他们的工作特别针对削弱工人并加剧不平等,尤其是在没有提供替代方案或减轻对工人阶级的负面影响的情况下,高薪的人工智能研究人员继续开发人工智能在道德上是不合适的。

顺便说一句,这是人工智能使用的商业案例,也是 OpenAI 实现盈利的主要途径。

当 Igor Babuschkin 修复 Grok 使其不再说 Trump 和 Musk 应该被处死时,他找到了任何人工智能在回答伦理问题时应做的正确事情。它根本不应该回答。聊天机器人没有能力完成伦理的基本工作——从思考什么是美好的生活,到理解措辞的微妙之处,再到识别伦理问题的社会潜台词。对于聊天机器人无法回答的问题,它应该保持沉默。

我从生成式人工智能工具中得到的压倒性印象是,它们是由那些不知道如何思考并且宁愿不思考的人创造的。不幸的是,我认为人工智能还没有先进到能够做到这一点。弄清楚什么算作伦理问题不仅仅是语言模式匹配的游戏;给我任何关于什么算作伦理问题的语言规则,我可能都能想出如何违反它们。伦理问题可以被视为一种技术悬垂,使 ChatGPT 成为一个魔法学徒式的机器。

科技公司一直在解雇他们的伦理学家,所以我想我将不得不以我明显不合格的眼光来看待这个问题的实际意义。许多与人工智能聊天机器人交谈的人都很孤独。其中一些是儿童。聊天机器人已经多次建议他们的用户——不止一次——自杀、杀害他人、违反同意年龄法,并进行自我伤害。Character.AI 现在卷入了一场诉讼,以确定它是否应该为一名 14 岁儿童的自杀负责。如果我提到的研究是正确的,那么任何使用人工智能的人都已经被削弱了批判性思维——所以他们可能更无法抵抗糟糕的人工智能建议。

如果我正在思考一个伦理问题,我可能会和同事讨论,或者和朋友在酒吧里讨论,或者阅读我尊重的哲学家的作品。但我也是一位已经思考伦理问题几十年的中年女性,而且我很幸运有很多朋友。如果我是一个孤独的青少年,我问聊天机器人这样一个问题,我可能会如何处理这个回答?如果我相信人工智能比我更聪明,我可能会如何受到这个回答的影响?我会在现实世界中应用这些结果吗?

事实上,我从生成式人工智能工具中得到的压倒性印象是,它们是由那些不知道如何思考并且宁愿不思考的人创造的。开发者在这里没有封锁伦理思考,这与整个 OpenAI 项目的普遍缺乏思考是一致的。

思考你自己的伦理——关于如何生活——是那种不能也不应该外包的事情。人工智能背后的意识形态可能最好被理解为粗心的反人文主义。从人工智能行业的行为——吸收互联网上的每一篇文字和艺术作品作为训练数据——可以推断出它对人文主义工作的态度:它是微不足道的,不值得尊重,很容易被机器输出所取代。

Grok、ChatGPT 和 Gemini 被营销为“节省时间”的设备,旨在让我免于写作和思考的工作。但我不想避免这些事情。写作就是思考,思考是追求美好生活的重要组成部分。阅读也是思考,而且是一种神奇的思考。阅读别人的文字是我们了解成为别人的唯一方式之一。当你阅读这些句子时,你正在思考我的实际想法。(亲密,不是吗?)我们甚至可以通过阅读来时间旅行——Iris Murdoch 可能已经去世,但《善的主权》仍然存在。柏拉图已经去世了几千年,但他的作品仍然是机智的伴侣。康德——好吧,关于康德无可比拟的散文风格,说得越少越好。

抛开人工智能能做或不能做的其他一切。思考你自己的伦理——关于如何生活——是那种不能也不应该外包的事情。ChatGPT 的文档表明,该公司希望人们依赖他们不可靠的技术来解决伦理问题,这本身就是一个坏兆头。当然,借用 Upton Sinclair 的一句话,当人工智能工程师的薪水取决于他们做出那个决定时,很难让他们理解他们正在做出一个糟糕的决定。