共计 2227 个字符,预计需要花费 6 分钟才能阅读完成。

在智能浏览器逐渐改变上网方式的今天,如果你希望加入这一潮流,同时又不愿意依赖第三方 AI,那么目前市面上只有一个选择——BrowserOS。

智能浏览器的兴起似乎预示着又一场浏览器大战的开启,而这次的核心是“更智能”的工具。然而,这种变革也带来了一个重大问题:如果全球每个人都在使用智能浏览器,这些智能任务将消耗大量电力,可能导致电价飙升,并对气候产生深远的负面影响。

应对这一挑战的一个解决方案是:本地 AI。在我偶尔需要使用 AI 时,我总是选择在本地运行,特别是使用 Ollama。遗憾的是,市场上几乎所有的智能浏览器都依赖基于云的 AI。对我而言,这种方式使得这些智能浏览器变得不可行。我不仅不愿进一步增加电网负担,更希望将所有查询保留在本地,以避免第三方将其用于训练或分析。

我发现有两款智能浏览器可以与本地 AI 配合使用:BrowserOS 和 Opera Neon。然而,目前只有 BrowserOS 向公众开放。BrowserOS 支持 Linux、MacOS 和 Windows。要与本地安装的 AI 一起使用,需要安装 Ollama 并下载支持智能浏览的模型,例如 qwen2.5:7b。

我一直在测试 BrowserOS,发现它是智能浏览器市场中的一个可靠选择。事实上,我发现它的表现与依赖云 AI 的浏览器不相上下,且不会带来负面影响或隐私问题。

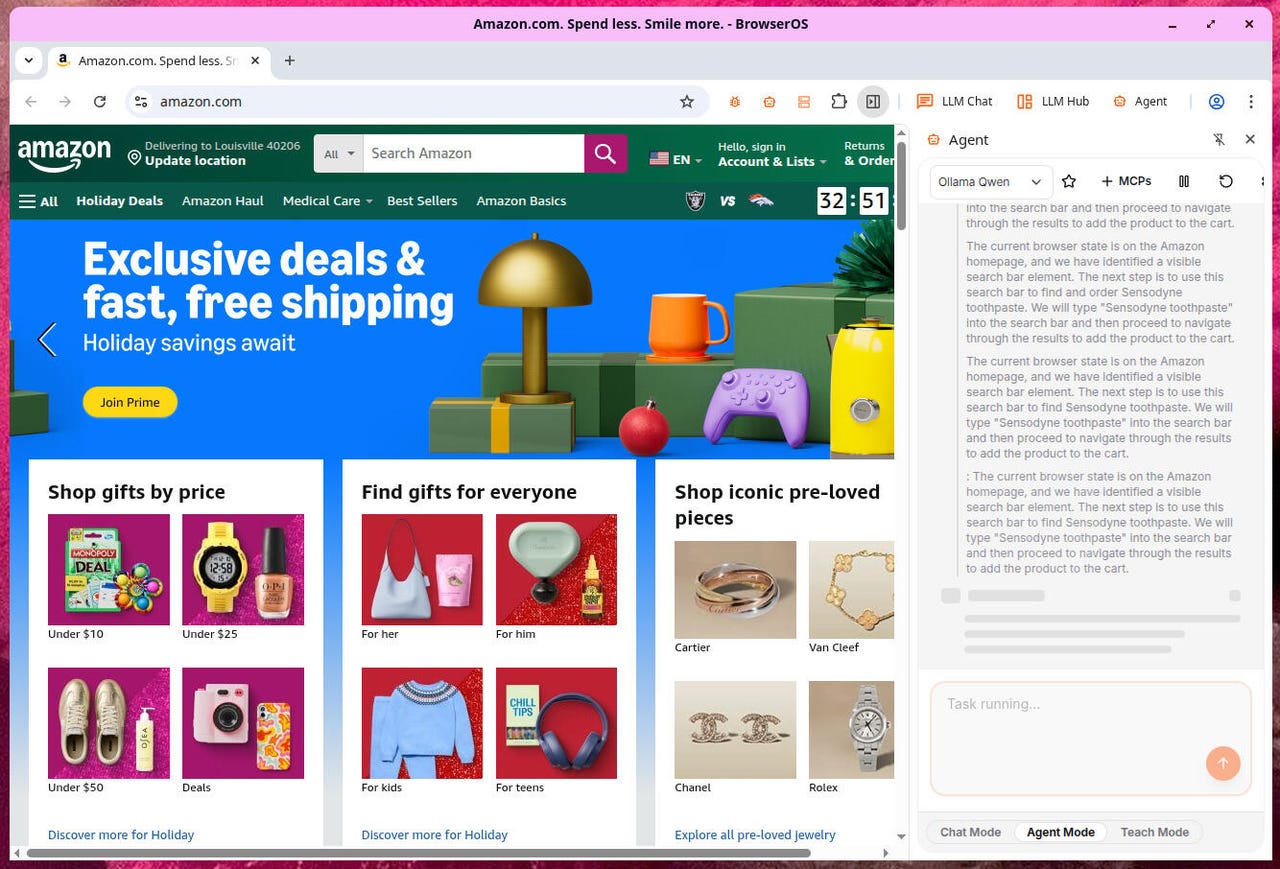

一旦我将 BrowserOS 设置为与 Ollama 配合使用(稍后会详细介绍),我打开了智能助手并运行了以下查询:打开 amazon.com 并搜索支持 Pixel 9 Pro 的无线充电支架。设置 BrowserOS 的智能工具花了一些时间,但一旦完成,它运行得非常完美。

需要注意的是:以这种方式使用 BrowserOS 需要相当多的系统资源,因此如果电脑性能不足,可能会遇到困难。根据 Ollama 网站的信息,运行本地 AI 的最低内存要求如下:

- 最低(8GB):这是入门的最低要求,允许运行较小的模型,通常在 3B 到 7B 参数范围内。

- 推荐(16-32GB):为了获得更流畅的体验并能够运行更强大的 13B 模型,建议使用 16GB 内存。要舒适地处理 30B+ 模型,应至少配备 32GB 内存。

- 大型模型(64GB+):要运行最大且最强大的模型,例如 70B 参数变体,需要 64GB 或更多的内存。

根据经验,最低内存要求并不够用。我的 System76 Thelio 台式机配备了 32GB 内存,这套配置对我的需求来说勉强够用。如果想使用更大的 LLM(或者希望智能任务运行得更快),建议使用 64GB+ 的内存。即使有 32GB 内存,智能任务也可能较慢,尤其是在运行其他应用程序和服务时。

在资源充足的情况下,BrowserOS 将顺利完成你的智能任务。但如何实现呢?下面将进行详细说明。

安装 Ollama

由于 Ollama 可以轻松安装在 MacOS 和 Windows 上,只需从 Ollama 下载页面下载二进制安装程序即可,这里将展示如何在 Linux 上安装。

1. 打开终端应用程序

首先需要打开一个终端应用程序。

2. 运行安装命令

接下来,运行以下命令在 Linux 上安装 Ollama:

curl -fsSL https://ollama.com/install.sh | sh

安装完成后,可以下载支持智能浏览器的模型。这里选择 qwen2.5:7b。要拉取该模型,运行以下命令:

ollama pull qwen2.5:7b

模型拉取完成后,接下来需要配置 BrowserOS 以使用该模型。

配置 BrowserOS

让我们配置 BrowserOS 以使用 Ollama。

1. 打开 BrowserOS AI 设置

打开 BrowserOS 应用程序,然后指向:

chrome://settings/browseros-ai

2. 选择 Ollama

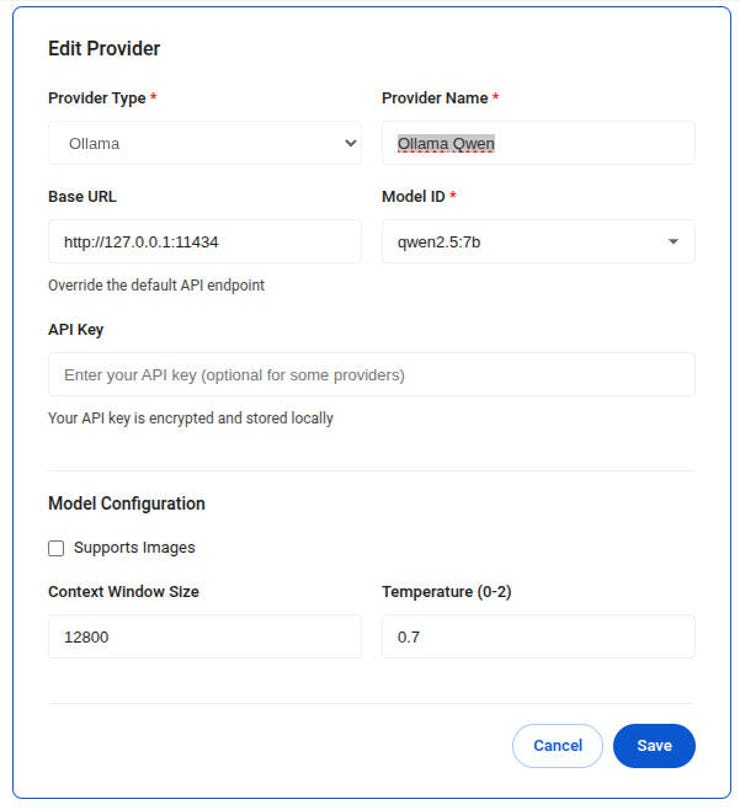

在打开的窗口中,点击与 Ollama 关联的使用按钮。完成此步骤后,需要按如下方式配置 Ollama:

- 提供者类型 – Ollama

- 提供者名称 – Ollama Qwen

- 基础 URL – 保持不变,除非在局域网内的不同服务器上使用 Ollama,此时将 127.0.0.1 替换为主机服务器的 IP 地址

- 模型 ID – qwen2.5:7b

- 上下文窗口大小 – 12800(但仅当系统性能强大时;否则,选择较小的数字)

- 温度 – 1

确保选择正确的模型并增加上下文窗口大小。

截图由 Jack Wallen/ZDNET 提供

确保将新提供者设置为默认。

3. 停止并启动 Ollama 服务

为了让 BrowserOS 与 Ollama 配合使用,首先需要停止 Ollama 服务。在 Linux 上,运行以下命令:

sudo systemctl stop ollama

服务停止后,需要启用 CORS(跨域资源共享)启动它。在 Linux 和 MacOS 上,运行以下命令:

OLLAMA_ORIGINS=’*’ ollama serve

在 Windows PowerShell 中,运行以下命令:

$env:OLLAMA_ORIGINS=’*’; ollama serve

在 Windows 命令行中,运行以下命令:

set OLLAMA_ORIGINS=* && ollama serve

使用新提供者

此时,可以打开 BrowserOS 中的智能侧边栏并运行智能查询,例如我之前建议的:打开 amazon.com 并搜索支持 Pixel 9 Pro 的无线充电支架。BrowserOS 将执行任务,最终打开一个符合上述搜索条件的标签页。

截图由 Jack Wallen/ZDNET 提供

使用智能浏览器确实需要一些适应,但一旦习惯,会发现它非常有用。通过使用本地安装的服务,使用 AI 时也能少一些内疚感。