共计 1275 个字符,预计需要花费 4 分钟才能阅读完成。

苹果公司近期发布的一项研究揭示了模拟推理(SR)模型的局限性,尤其是在面对需要系统性思维的新问题时。这项名为 ’ 思维幻觉:通过问题复杂性视角理解推理模型的优势与局限性 ’ 的研究由 Parshin Shojaee 和 Iman Mirzadeh 领导,团队成员包括 Keivan Alizadeh、Maxwell Horton、Samy Bengio 和 Mehrdad Farajtabar。

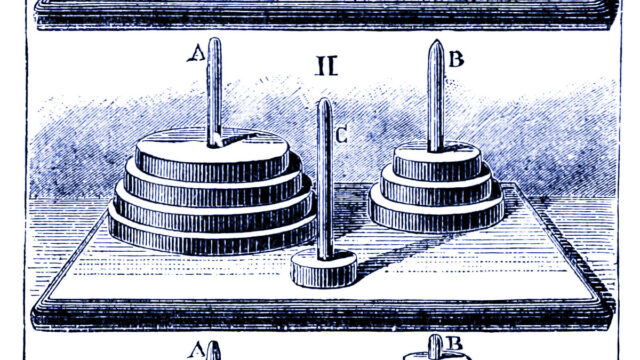

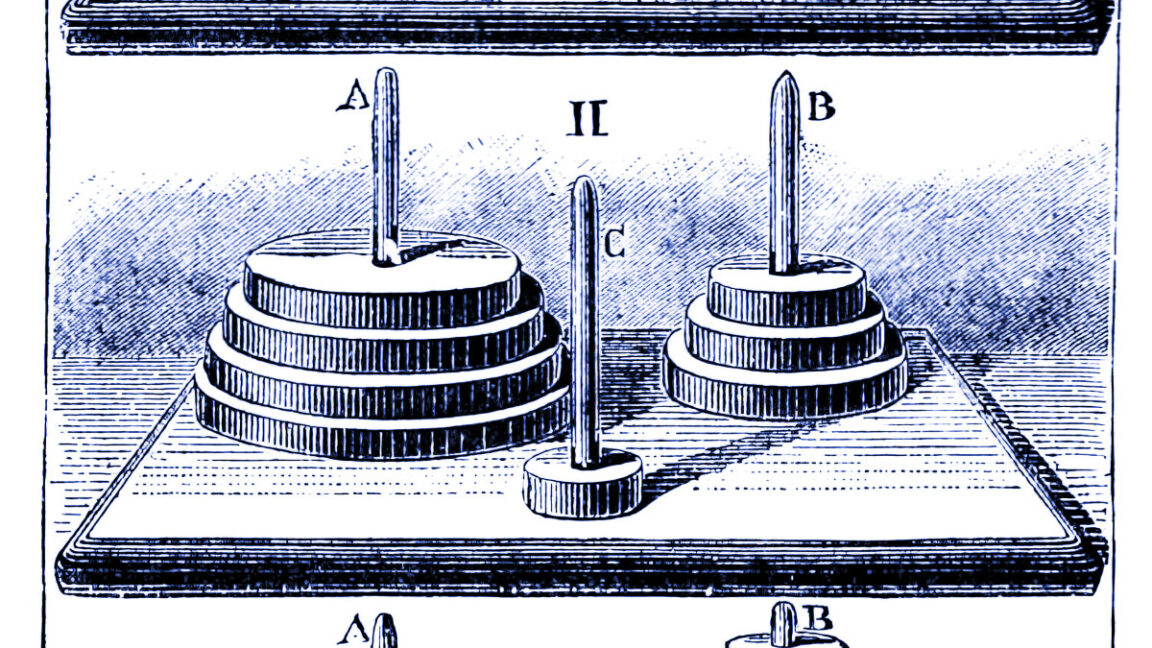

研究人员通过一系列经典谜题,如《河内塔》、跳棋、渡河和积木世界,测试了 OpenAI 的 o1 和 o3、DeepSeek-R1 以及 Claude 3.7 Sonnet Thinking 等模型的推理能力。研究发现,这些模型在新数学证明上的得分普遍较低,与四月份美国数学奥林匹克(USAMO)的研究结果相似。

-

在近 200 次尝试中,没有一个模型能够完美证明新数学问题,得分大多低于 5%,只有一个模型达到了 25%。AI 研究员 Gary Marcus 认为这一研究结果 ’ 对 LLMs 来说相当具有毁灭性 ’,并指出即使提供了明确的《河内塔》解决算法,模型的表现也没有改善。

苹果团队还发现,随着问题复杂性的增加,模拟推理模型最初会生成更多的思维标记,但在超过某个阈值后,尽管有足够的计算资源,它们会减少推理努力。此外,模型失败方式的不一致性也令人困惑,例如 Claude 3.7 Sonnet 在《河内塔》中最多可以执行 100 步正确移动,但在渡河谜题中仅执行了五步就失败了。

然而,并非所有研究人员都同意这些结果展示了基本推理局限性的解释。多伦多大学经济学家 Kevin A. Bryan 认为,观察到的局限性可能反映了故意的训练约束,而不是固有的无能。他指出,未指明的行业基准显示 ’ 随着推理中使用的标记增加,性能在几乎所有问题领域都严格增加 ’,但部署的模型有意限制这一点,以防止 ’ 过度思考 ’ 简单查询。

软件工程师 Sean Goedecke 也提出了类似的批评,指出当面对需要超过 1000 步的《河内塔》时,DeepSeek-R1’ 立即决定 ’ 手动生成所有这些移动是不可能的 ’,因为它需要跟踪超过一千步。因此,它试图寻找捷径并失败。’Goedecke 认为这代表了模型选择不尝试完成任务,而不是无法完成它。

独立 AI 研究员 Simon Willison 则认为,《河内塔》方法 ’ 并不是一个明智的方式来应用 LLMs,无论是否带有推理 ’,并建议失败可能仅仅反映了上下文窗口中的标记用尽,而不是推理缺陷。苹果研究人员自己也警告不要过度推断其研究结果,承认 ’ 谜题环境代表了推理任务的狭窄切片,可能无法捕捉到现实世界或知识密集型推理问题的多样性。’

尽管这些研究可能表明 SR 模型使用的扩展上下文推理技巧可能并不是通向通用智能的途径,但这并不意味着这些 AI 模型毫无用处。生成式 AI 领域的许多内容都非常新,甚至其发明者尚未完全理解这些技术的工作原理。然而,即使复杂的模式匹配机器在了解其缺点的情况下,也可以为使用它们的人执行节省劳动力的任务。正如 Marcus 所承认的,’ 至少在接下来的十年里,LLMs(无论是否带有推理时间 ’ 推理 ’)将继续有其用途,尤其是在编码、头脑风暴和写作方面。’