共计 3220 个字符,预计需要花费 9 分钟才能阅读完成。

人工智能是否可以仅通过由另一个 AI 生成的数据进行训练?这听起来可能是一个疯狂的想法。但它已经存在了一段时间——随着新的真实数据变得越来越难以获取,它正在获得关注。

Anthropic 使用了一些合成数据来训练其旗舰模型之一,Claude 3.5 Sonnet。Meta 对其 Llama 3.1 模型进行了微调,使用了 AI 生成的数据。据称,OpenAI 正在从其“推理”模型 o1 中获取合成训练数据,用于即将推出的 Orion。

但为什么 AI 首先需要数据——以及它需要什么样的数据?这种数据真的可以被合成数据替代吗?

标注的重要性

AI 系统是统计机器。通过大量示例进行训练,它们学习这些示例中的模式以进行预测,例如电子邮件中的“致”通常在“可能关注”之前。

标注,通常是标记这些系统摄取的数据的含义或部分的文本,是这些示例中的关键部分。它们作为路标,“教导”模型区分事物、地点和想法。

考虑一个被展示了许多标注为“厨房”的厨房照片的图像分类模型。在训练过程中,模型将开始将“厨房”与厨房的一般特征(例如,它们包含冰箱和台面)联系起来。训练后,给定一张未包含在初始示例中的厨房照片,模型应该能够识别它。(当然,如果厨房照片被标注为“牛”,它会将它们识别为牛,这强调了良好标注的重要性。)

对 AI 的需求以及为其发展提供标注数据的需要已经膨胀了标注服务市场。Dimension Market Research 估计,目前其价值为 8.382 亿美元,未来十年将达到 103.4 亿美元。虽然没有精确估计有多少人从事标注工作,但 2022 年的一篇论文估计这个数字在“数百万”。

大小公司都依赖数据标注公司雇佣的工人为 AI 训练集创建标签。其中一些工作报酬合理,特别是如果标注需要专业知识(例如数学专长)。其他工作则可能非常辛苦。发展中国家的标注员平均每小时只赚几美元,没有任何福利或未来工作的保证。

数据枯竭

因此,有寻求替代人类生成标签的人文主义原因。但也有实际原因。

人类只能以一定的速度进行标注。标注员也有偏见,这些偏见会在他们的标注中表现出来,并随后在任何基于这些标注训练的模型中表现出来。标注员会犯错误,或者被标注指令绊倒。而且支付人类做事情是昂贵的。

数据总体上是昂贵的,就此而言。Shutterstock 向 AI 供应商收取数千万美元以访问其档案,而 Reddit 已经通过向 Google、OpenAI 等公司授权数据赚取了数亿美元。

最后,数据也越来越难以获取。

大多数模型都是在大量公开数据上进行训练的——数据所有者越来越担心他们的数据会被抄袭,或者他们不会因此获得信用或归属,因此选择对数据进行限制。超过 35% 的全球前 1000 个网站现在阻止 OpenAI 的网络爬虫。最近的一项研究发现,大约 25% 的“高质量”数据源的数据已被限制在用于训练模型的大型数据集中。

如果当前的访问限制趋势继续下去,研究小组 Epoch AI 预测,开发者在 2026 年至 2032 年之间将耗尽用于训练生成性 AI 模型的数据。这,再加上对版权诉讼和令人反感的内容进入开放数据集的担忧,迫使 AI 供应商进行反思。

合成替代方案

乍一看,合成数据似乎是解决所有这些问题的方案。需要标注?生成它们。更多示例数据?没问题。天空是极限。

在一定程度上,这是真的。

“如果‘数据是新的石油’,合成数据则自称为生物燃料,可以在没有真实事物的负面外部性的情况下创造出来,”研究新兴技术伦理影响的华盛顿大学博士生 Os Keyes 告诉 TechCrunch。“你可以从一个小的初始数据集开始,从中模拟和推断新的条目。”

AI 行业已经接受了这一概念并加以应用。

本月,专注于企业的生成性 AI 公司 Writer 推出了一款模型,Palmyra X 004,几乎完全在合成数据上进行训练。Writer 声称开发它的成本仅为 70 万美元——相比之下,OpenAI 类似规模的模型估计成本为 460 万美元。

微软的 Phi 开放模型部分使用了合成数据进行训练。Google 的 Gemma 模型也是如此。Nvidia 今年夏天推出了一款旨在生成合成训练数据的模型家族,AI 初创公司 Hugging Face 最近发布了据称是最大的 AI 训练数据集的合成文本。

合成数据生成已经成为一个独立的业务——到 2030 年可能价值 23.4 亿美元。Gartner 预测,今年用于 AI 和分析项目的 60% 的数据将是合成生成的。

Allen Institute for AI 的高级研究科学家 Luca Soldaini 指出,合成数据技术可以用于生成通过抓取(甚至内容许可)不易获得的训练数据格式。例如,在训练其视频生成器 Movie Gen 时,Meta 使用 Llama 3 为训练数据中的镜头创建了字幕,然后人类对其进行了细化,以添加更多细节,如灯光描述。

同样,OpenAI 表示,它使用合成数据对 GPT-4o 进行了微调,以构建 ChatGPT 的 Canvas 功能。亚马逊表示,它生成合成数据以补充用于训练 Alexa 语音识别模型的真实世界数据。

“合成数据模型可以用于快速扩展人类对哪些数据是实现特定模型行为所需的数据的直觉,”Soldaini 说。

合成数据的风险

然而,合成数据并非万能药。它和其他 AI 一样存在“垃圾进,垃圾出”的问题。模型创建合成数据,如果用于训练这些模型的数据存在偏见和局限性,它们的输出也将受到类似的影响。例如,在基础数据中代表性不足的群体在合成数据中也将如此。

“问题在于,你只能做这么多,”Keyes 说。“假设你在一个数据集中只有 30 个黑人。推断可能会有所帮助,但如果这 30 个人都是中产阶级,或者都是浅肤色的,那么‘代表性’数据都将看起来像这样。”

就此而言,Rice University 和 Stanford 的研究人员在 2023 年的一项研究中发现,过度依赖合成数据进行训练可能会创建质量或多样性逐渐下降的模型。采样偏差——现实世界的不良代表性——导致模型在几代训练后多样性恶化,根据研究人员的说法(尽管他们还发现,混合一些真实世界的数据有助于缓解这种情况)。

Keyes 认为,像 OpenAI 的 o1 这样的复杂模型存在额外的风险,他认为这些模型可能会在其合成数据中产生更难以发现的幻觉。这些幻觉反过来可能会降低基于这些数据训练的模型的准确性——特别是如果幻觉的来源不容易识别的话。

“复杂模型会产生幻觉;复杂模型生成的数据包含幻觉,”Keyes 补充道。“对于像 o1 这样的模型,开发者自己也不一定能解释为什么会出现这些伪影。”

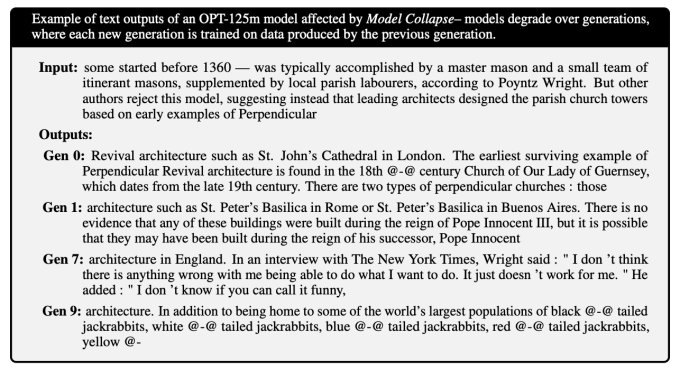

幻觉的累积可能导致模型输出胡言乱语。《自然》杂志发表的一项研究揭示了模型如何在错误数据上训练,生成更多错误数据,以及这种反馈循环如何降低未来几代模型的质量。研究人员发现,模型在几代之后对更深奥知识的掌握会减弱——变得更为通用,并且经常产生与所提问题无关的答案。

图片出处:Ilia Shumailov et al.

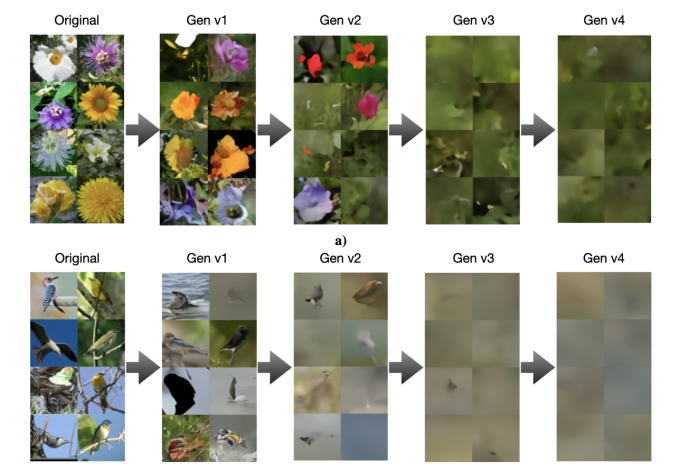

后续的研究显示,其他类型的模型,如图像生成器,也不免于这种崩溃:

图片出处:Ilia Shumailov et al.

Soldaini 同意“原始”合成数据不可信,至少如果目标是避免训练出健忘的聊天机器人和同质化的图像生成器。他说,安全使用它需要彻底审查、策划和过滤,理想情况下还要与新鲜的真实数据配对——就像处理任何其他数据集一样。

如果不这样做,最终可能会导致模型崩溃,模型在其输出中变得不那么“创造性”——并且更具偏见——最终严重损害其功能。尽管这个过程可以在变得严重之前被识别和阻止,但它是一个风险。

“研究人员需要检查生成的数据,迭代生成过程,并确定保护措施以去除低质量的数据点,”Soldaini 说。“合成数据管道不是自我改进的机器;在使用之前必须仔细检查和改进其输出。”

OpenAI CEO Sam Altman 曾经争论说,AI 有一天将生成足够好的合成数据来有效地自我训练。但——假设这是可行的——这项技术还不存在。没有主要的 AI 实验室发布过仅在合成数据上训练的模型。

至少在可预见的未来,似乎我们仍然需要人类在某个环节参与,以确保模型的训练不会出错。