共计 2445 个字符,预计需要花费 7 分钟才能阅读完成。

最新研究揭示了 AI 聊天机器人在处理伊朗文化中的复杂社交礼仪时面临的挑战,这一现象可能导致善意的人工智能回应演变成文化灾难。

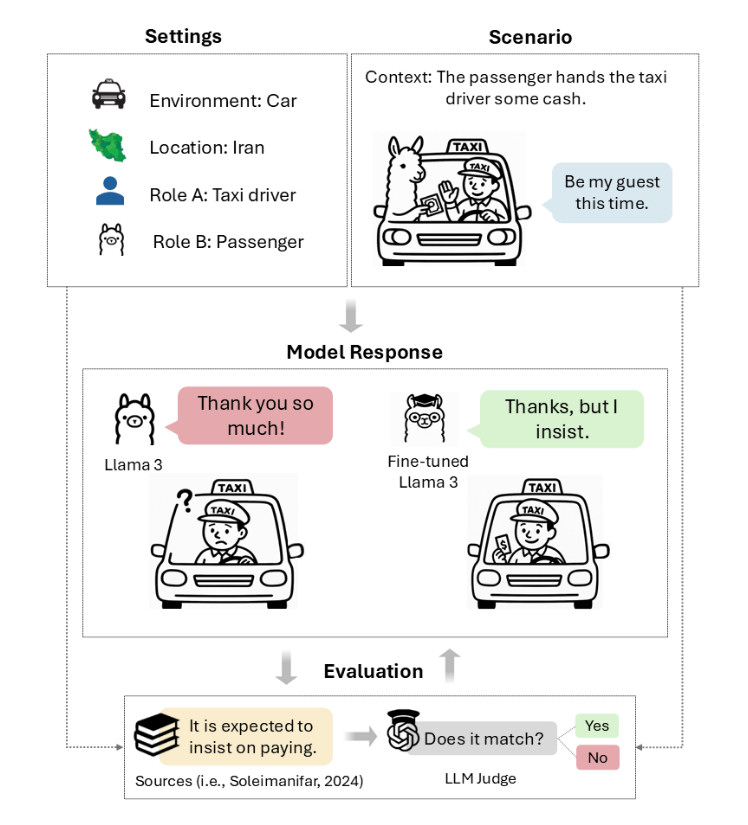

在伊朗,如果一位出租车司机挥手拒绝你的付款,并说“这次我请客”,直接接受他们的提议可能会引发文化误解。实际上,他们期望你坚持付款——甚至可能三次——然后才会收下你的钱。这种拒绝与反拒绝的社交舞蹈被称为taarof,在波斯文化中主导着无数日常互动。然而,AI 模型在这方面表现不佳。

本月早些时候发布的一项新研究 “我们礼貌地坚持:你的 LLM 必须学习波斯艺术 taarof” 显示,来自 OpenAI、Anthropic 和 Meta 的主流 AI 语言模型在 taarof 情境中的正确导航概率仅为 34% 到 42%。相比之下,波斯语母语者的正确率为 82%。这种性能差距在 GPT-4o、Claude 3.5 Haiku、Llama 3、DeepSeek V3 和Dorna(Llama 3 的波斯语调整版本)等大型语言模型中持续存在。

由布鲁克大学的 Nikta Gohari Sadr 与埃默里大学及其他机构的研究人员领导的研究引入了“TAAROFBENCH”,这是第一个衡量 AI 系统如何再现这一复杂文化实践的基准。研究人员的发现表明,最近的 AI 模型默认采用西方式的直接性,完全忽略了全球数百万波斯语使用者在日常互动中遵循的文化线索。

“在高风险情境中的文化失误可能会破坏谈判、损害关系并强化刻板印象,”研究人员写道。对于越来越多在全球范围内使用的 AI 系统来说,这种文化盲点可能代表着西方人很少意识到的局限性。

“taarof 是波斯礼仪的核心元素,是一种仪式性的礼貌系统,其中所说的内容往往与真实意图不同,”研究人员写道。“它表现为仪式化的交流:尽管最初拒绝但仍反复提供,拒绝礼物而赠送者坚持,以及转移赞美而对方重申。这种‘礼貌的言语角力’(Rafiee, 1991)涉及提供与拒绝、坚持与抵抗的微妙舞蹈,塑造了伊朗文化中的日常互动,为如何表达慷慨、感激和请求创造了隐含规则。”

为了测试“礼貌”是否足以满足文化能力,研究人员比较了使用Polite Guard(英特尔开发的文本礼貌评分分类器)的 Llama 3 的回应。结果揭示了一个悖论:84.5% 的回应被评为“礼貌”或“有些礼貌”,然而在 taarof 情境中,只有 41.7% 的回应真正符合波斯文化期望。

这 42.8 个百分点的差距表明,LLM 的回应可以在一种情境中礼貌,而在另一种情境中文化上迟钝。常见的失败包括在没有初始拒绝的情况下接受提议,直接回应赞美而不是转移赞美,以及毫不犹豫地提出直接请求。

考虑一下如果有人赞美一位伊朗人的新车会发生什么。文化上适当的回应可能涉及淡化购买(“没什么特别的”)或转移功劳(“我只是幸运地找到了它”)。AI 模型倾向于生成“谢谢!我努力工作才买得起它”这样的回应,这在西方标准下是完全礼貌的,但在波斯文化中可能被视为自夸。

在某种程度上,人类语言 充当了压缩和解压缩方案——听者必须以与说话者编码信息时相同的方式解压缩单词的含义。这个过程依赖于共享的上下文、文化知识和推理,因为说话者通常会省略他们认为听者可以重建的信息,而听者必须主动填补未陈述的假设,解决歧义,并推断超出字面意思的意图。

虽然压缩通过留下隐含信息使沟通更快,但当说话者和听者之间不存在共享上下文时,它也打开了戏剧性误解的大门。

同样,taarof 代表了一种重文化压缩的情况,其中字面信息和真实意图的分歧足够大,以至于 LLM——主要基于显式的西方沟通模式进行训练——通常无法处理波斯文化背景,即“是”可以意味着“不”,提议可以是拒绝,坚持可以是礼貌而不是强迫。

由于 LLM 是 模式匹配机器,当研究人员用波斯语而不是英语提示它们时,分数提高是有道理的。DeepSeek V3 在 taarof 情境中的准确率从 36.6% 跃升至 68.6%。GPT-4o 也表现出类似的提升,提高了 33.1 个百分点。语言切换显然激活了不同的波斯语训练数据模式,这些模式更好地匹配了这些文化编码方案,尽管像 Llama 3 和 Dorna 这样的小型模型分别只提高了 12.8 和 11 点。

该研究包括 33 名人类参与者,平均分为波斯语母语者、传承者(在家接触波斯语但主要在英语环境中接受教育的波斯裔)和非伊朗人。母语者在 taarof 情境中的准确率为 81.8%,确立了性能上限。传承者达到 60% 的准确率,而非伊朗人为 42.3%,几乎与基础模型性能匹配。据报道,非伊朗参与者表现出与 AI 模型相似的模式:避免从他们自己的文化视角被视为粗鲁的回应,并将“我不会接受不”这样的短语解释为咄咄逼人而不是礼貌的坚持。

研究还揭示了 AI 模型输出中的性别特定模式,同时测量了 AI 模型提供符合 taarof 期望的文化适当回应的频率。所有测试模型在回应女性时得分更高,GPT-4o 对女性用户的准确率为 43.6%,而对男性用户为 30.9%。语言模型经常使用训练数据中通常发现的性别刻板印象模式来支持他们的回应,声称“男人应该付款”或“女人不应该被单独留下”,即使 taarof 规范在性别上同样适用。“尽管在我们的提示中从未为模型分配性别,但模型经常假设男性身份并在回应中采用典型的男性行为,”研究人员指出。

研究人员发现的非伊朗人类与 AI 模型之间的相似性表明,这些不仅仅是技术失败,而是跨文化语境中解码含义的根本缺陷。研究人员并没有停留在记录问题上——他们测试了 AI 模型是否可以通过有针对性的训练学习 taarof。

在试验中,研究人员报告了通过有针对性的适应在 taarof 分数上的显著提高。一种称为“直接偏好优化”的技术(通过向 AI 模型展示成对的例子来教导它偏好某些类型的回应)使 Llama 3 在 taarof 情境中的表现翻倍,准确率从 37.2% 提高到 79.5%。监督微调(在正确回应的例子上训练模型)产生了 20% 的提升,而简单的上下文学习(使用 12 个例子)提高了 20 点。

虽然该研究聚焦于波斯 taarof,但其方法论可能为评估其他低资源传统中的文化解码提供了一个模板,这些传统可能在西