共计 1012 个字符,预计需要花费 3 分钟才能阅读完成。

MiniCPM-o 2.6:端侧多模态大模型的全新突破

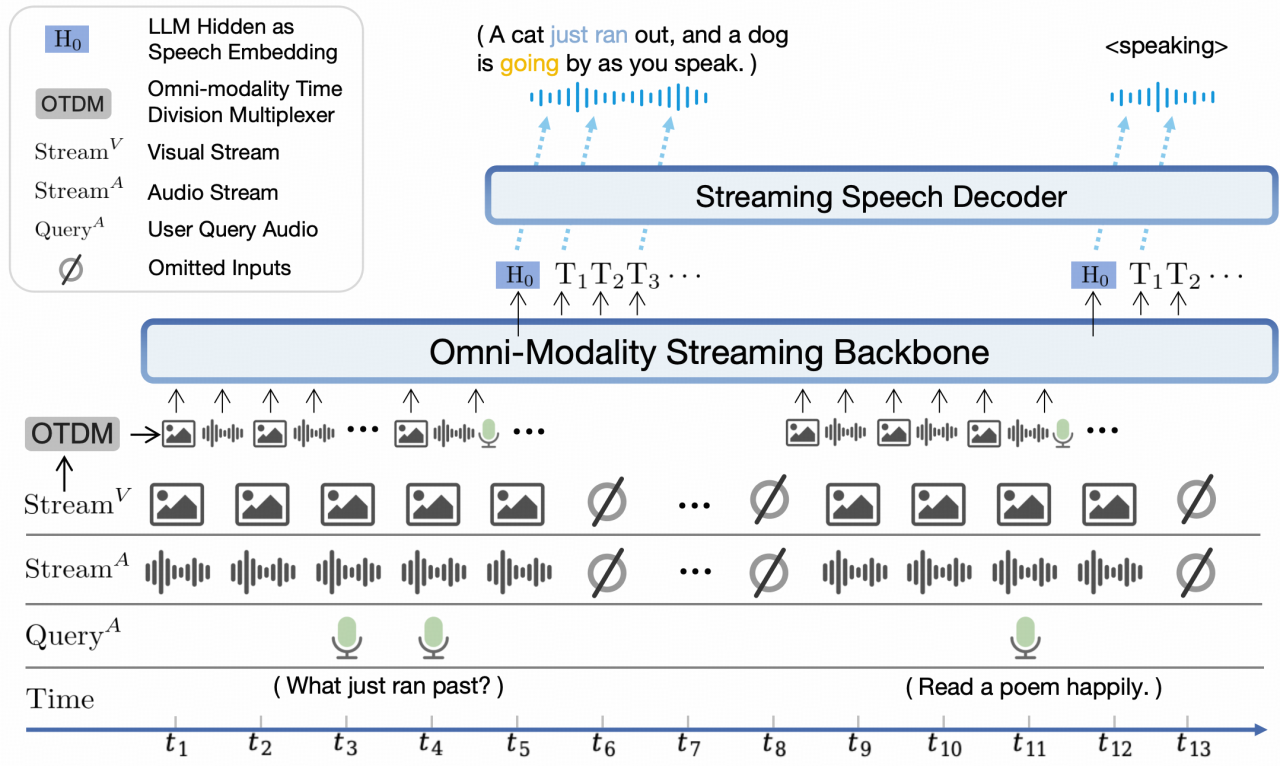

MiniCPM-o 2.6,这可是 MiniCPM 家族的最新王牌,性能杠杠的!它标志着端侧多模态大模型技术又攀上了一个新高峰。80 亿参数,听起来就厉害吧?视觉、语音、多模态流式能力,各个都是顶尖水平,直接对标 GPT-4o-202405,简直是开源社区里模态支持最丰富、性能最能打的选手。

它不光继承了 MiniCPM-V 2.6 的优点,还在语音方面搞出了新花样,支持可配置声音的中英双语语音对话,还能玩转情感、语速、风格控制,让你的互动体验更上一层楼!

MiniCPM-V 2.6:端侧实时多模态交互的里程碑

再说 MiniCPM-V 2.6,在多模态理解上可是取得了巨大进步,单图、多图、视频理解能力,通通超越了 GPT-4V!最让人惊艳的是,它竟然能在 iPad 这种端侧设备上实时理解视频!这在同类模型里,绝对是独一份的绝活。不仅如此,性能还比 GPT-4o mini、Gemini 1.5 Pro、Claude 3.5 Sonnet 这些大咖更为出色,稳坐多模态大模型领域的头把交椅。

MiniCPM 系列模型的部署与应用进展

MiniCPM 系列模型能有这么大的发展,还得感谢 llama.cpp 和 vLLM 这些好帮手。llama.cpp 的官方仓库已经正式支持 MiniCPM-V 2.6 和 MiniCPM-Llama3-V 2.5,各种大小的 GGUF 版本应有尽有,方便大家在不同设备上部署。有了 vLLM 的加持,推理效率更是飞速提升,部署起来也更灵活了。这些框架的支持,为模型的广泛应用打下了坚实的基础,大家可以根据自己的需求选择最适合的部署方案。

模型要能适应各种场景,微调能力必须过硬。MiniCPM 系列模型支持通过 SWIFT 框架进行微调,你可以根据自己的任务需求,量身定制模型。而且,它还支持多 GPU 推理,就算只有 12G/16G 这种低显存显卡,也能串行推理,大大降低了硬件成本。为了更高效地微调,还支持 LoRA 微调,让你在有限的计算资源下,也能轻松调整参数。这些微调功能,大大提高了模型的适用性和灵活性,用起来就是这么顺手!

为了满足大家各种各样的需求,MiniCPM 系列模型还提供了超多实用功能。比如,支持流式输出,让你在模型生成文本的同时就能实时查看和处理。还有自定义系统提示词,你可以根据不同场景设置不同的指令,更好地控制模型的行为和输出。这些功能不仅让模型更好用,也大大提升了在实际应用中的灵活性,真是太贴心了!